日記 9750

adw という名前でやらせていただいております

趣味

- AtCoder

ちょっとコーディングにハマった - 乗り鉄

乗り鉄ですがなにか

好きな言語

- rust

最近は rust 一筋でやらせていただいております

いつも使ってるリポジトリ

https://mirror.hashy0917.net/

※自動変更スクリプトも書いてます。 よければ使ってください。 → change0917

リンクとか

RT 専門です。 垢わけようか、迷ってます

ボイスロイド劇場が好きです。 一人称劇場大好き。

ASMR 毎日お世話になってたら耳ガアアになったので、ほどほどに癒されてます。

github アカウントです。

qiita でも書いてます。- BlueSky

bluesky 登録できた(今更)

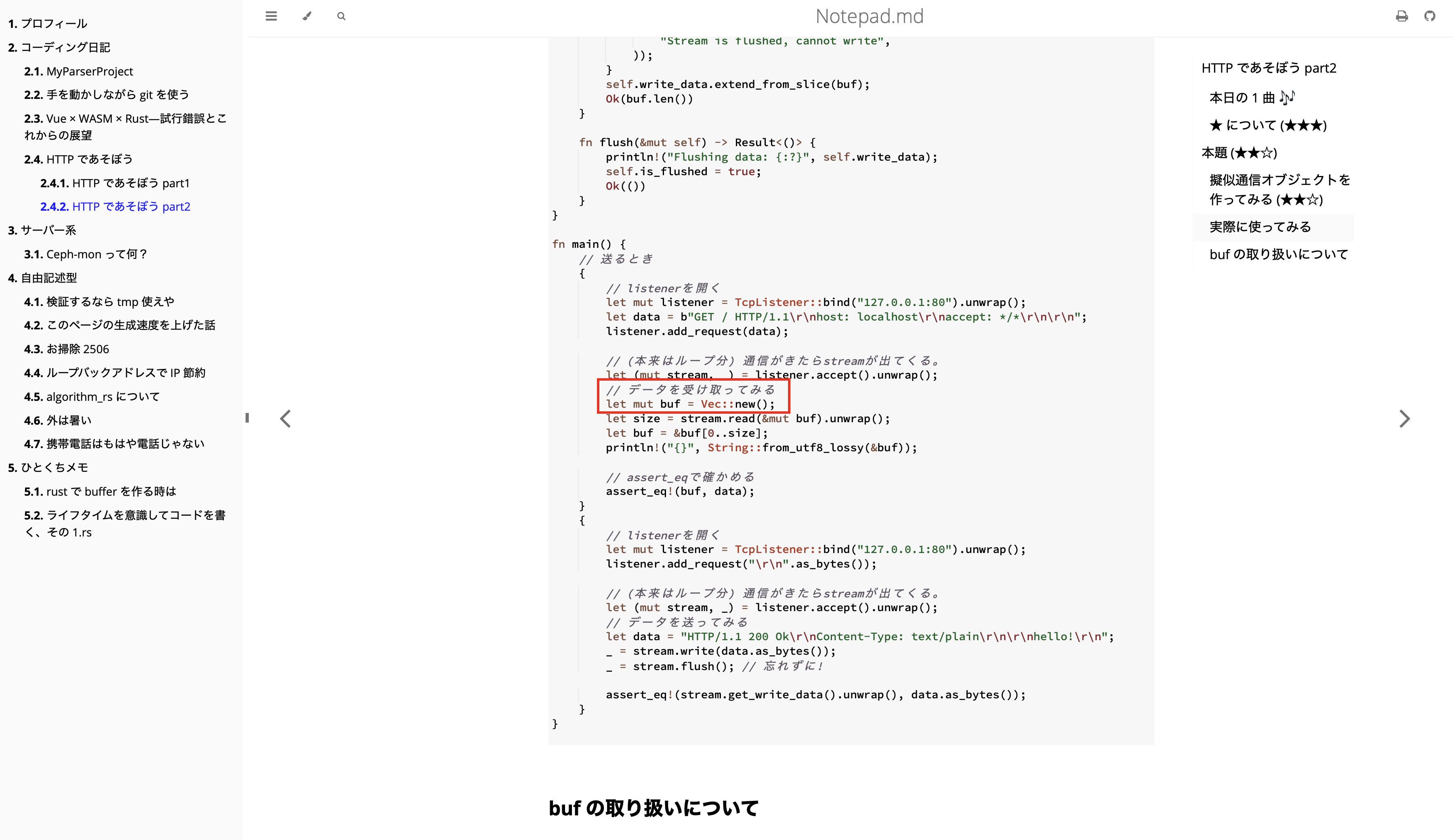

notepad.md について

- url: https://adw39.org

- repo: tam1192/tam1192

mdbookを使用した暫定ブログです。 今後機能つけて正式ブログにするか、wordpress 鯖立てるかは迷ってます。

github pages を使ってるので、そんなに落ちないと思います。 自宅鯖に移行した暁には落とさないようベストを尽くします。

ご意見募集中

当サイトのリポジトリにて、issue 募集中です!

- 投稿には github アカウントが必要です。

- テンプレート用意してます。 ぜひ活用してください。

ブックマーク

このページでは、日記さんが参考にしたサイトをリンク集として公開しております。

git 関連

rebase 関連

- How do I git rebase the first commit?

この記事では、最初のコミットを empty(空)にする方法が載っています。 最初のコミットを編集する必要がある場合もこの記事が参考になります。 - リポジトリを作り直した件

この記事では行えませんでしたが、実際は 1 の方法で解決できます

qiita でアップしました!

日記さんが qiita でアップした記事の紹介です。 qiita のマイページ

投稿方針について

qiita アップロードする情報は、こちらより真面目かつ正確な情報を伝えようと努力したものです。(実際はそうじゃないかも) また、qiita 記事のコメントはぜひ qiita のコメント欄にてお願いします!!

ここでは何書くの?

記事の紹介と、書いてて思ったことを書きます。

notepad.md お馴染み、主観マシマシです!

今更 type-c デビューしてみた

lightning 使ってるとどうしても type-c への対応が遅れるからね。仕方ないね。 (デビュー日: 2024 年中旬)

本日のひとこと

いつも聞いてるけど本当に明るい気分になれる!! って曲です。好き。 ミク愛してる。

書いた感想とか

久々に qiita に書きました。 結構 wikipedia 先生参考にした記事です。

ノートについて

notepad.md でも note 機能をつけて使ってます

note

これのことです!

ここには主に主観、感想とかを入れるようにしてます。 notepad.md でも感想などは Note にしてますが、qiita 記事ではさらに Note にしてます。 少しでも正確性を増しながら、自分ふうな記事を書けるようにしてるのです。

ところで type-c ハブ買った

type-c になってから 9in1 ハブなどを使うようになりました。 これかった、ugreen さんのは信用できるから

やっぱ便利ですね。hdmi も rj45 も使えるようになるし、カメラ関係で sd カードつかえるし、

何よりたくさんのポートついてると嬉しいよね!(その考えがそもそも古いという...)

pd 対応が良い

pd 対応の物だと、充電器からハブに、ハブから pc、もしくはスマホとスムーズに繋げられます。 これまた便利

ところで type-c 電力メーター買った

pd については書く気なかったのですが、電力メーター買っちゃったので無理やり書きました。 pd はだいぶ前から恩恵受けてました。(lightning 使えたので)

まとめ

記事にも書いてある通り、真面目に詳しくないことを無理やり書きましたので、

コメントお待ちしております。

以上、少しでも自分の認識を正しくしたいマン 日記さんでお送りしました。

ライフタイムを意識してコードを書く.rs

過去にひとくちメモとして載せていた記事を修正、qiitaに移したものです。

本日のひとこと

ちねつき。

そもそもひとことメモじゃなかっただろ!

そういうボリュームの記事ですが、後から見直すと内容が多い割に割と整理された記事と感じたので、qiitaに載せる記事にしました。

移行時に思ったところ

このサイトはmdbookで作られており、mdbookはrustコミュニティーによってrustで作られてます。

rustのドキュメントを書くのには相性がよく、rustのコードブロックはPlaygroundを通じてその場で実行できるほどです。

もちろん、 mdbook専用のものなので、 qiitaに移す際はコードが実行できないことを念頭におく必要があります。

そのため、実行してもらえる前提のコード・記事から、実行されない前提のコードに変更しました。 といってもそこまで変えてません。 そもそもコードは私にしては割と丁寧に作られてたので...

1時間かけずに移行できた

移行に1時間かけませんでした。 割と手早くできました。

以上

移行した時の裏話でした。

記事はこちら 記事へのコメントお待ちしております!!!

コーディング日記

github であげたコードに対する備忘録を載せております。

My Parser Project

CommandAPIを用いて生成したプロセスの標準入出力を管理するプログラムを書いていて、 その実験用に登場した「DesperatelyRustyToolBox」が 独自のコマンドラインを持つプログラムであった。

このプログラムをもっと拡張できるよう、高度な構文解析が必要と考えて登場したのがこのプロジェクト。

他にも登場経緯はあるが割愛。

自分用標準構成

自分用とあるが、実際rustで開発するにあたって必要であるカスタム型、便利ツール、開発方法、モデルを定義したもの。

要素は以下の通り

- CI/CDを実現するためにGithubActionsを積極採用

cargo buildとcargo testを自動化。さらに、cargo docも自動化。

mainにマージされた時はクリーンなコードを保てる。 - テスト駆動開発で開発を行う

せっかくCI/CDでテストの自動化を行ったんだから、書かないわけにはいかない。

公式にもある通り、テスト駆動開発で目標の見える化を実現。 - エラートレイトを実装したオリジナルのカスタムエラー型を用意

ちゃんとsourceまであるならsourceまで実現。

エラー発生箇所の特定を容易にするだけでなく、

Fromの実装で?シュガーシンタックスに対応、コードがより見やすく。 - 一般的なブランチモデルを採用

いわゆる

git flowに基づいたブランチモデルを採用する。

また、名前規則やコメント規則等々も今後まとめていきたい。

最終目標

このプロジェクトを使い回していけるように頑張りたい。

参考とか

- Rust でパーサコンビネータを作ってみる/nojima様

パーサーコンビネータの基本のきがここに載ってます。とても参考になります。

当プロジェクトでは部分的に実装を変えたりしてるが、ほとんど参考にして作ってます。 - BNFや構文解析についてのメモ

四則演算パーサー実装時に参考にしました。

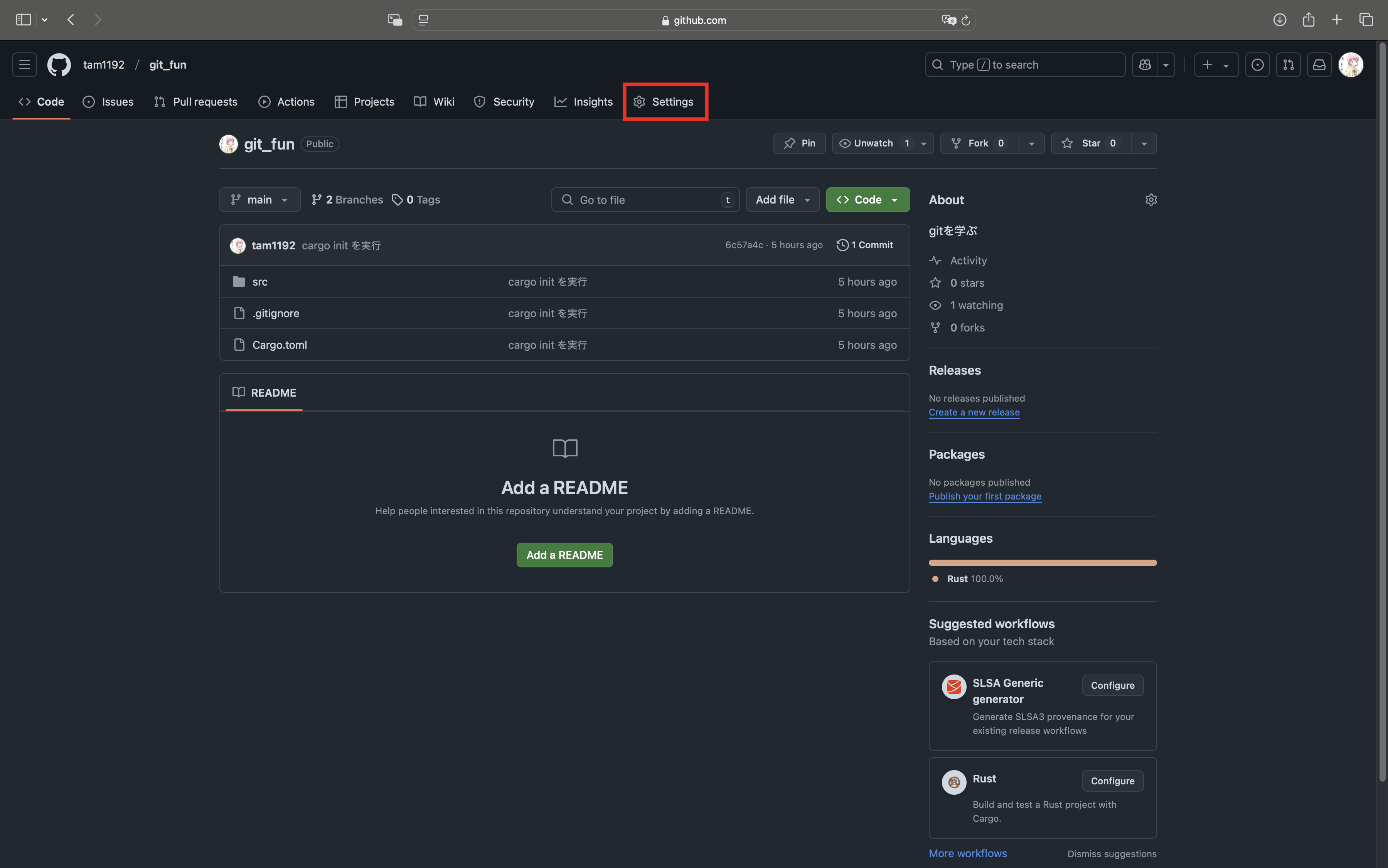

commit: first_commit

この記事はgitを用いながらrustでプログラムを書いてみよう っていう記事です。

warning

この記事は途中までです。

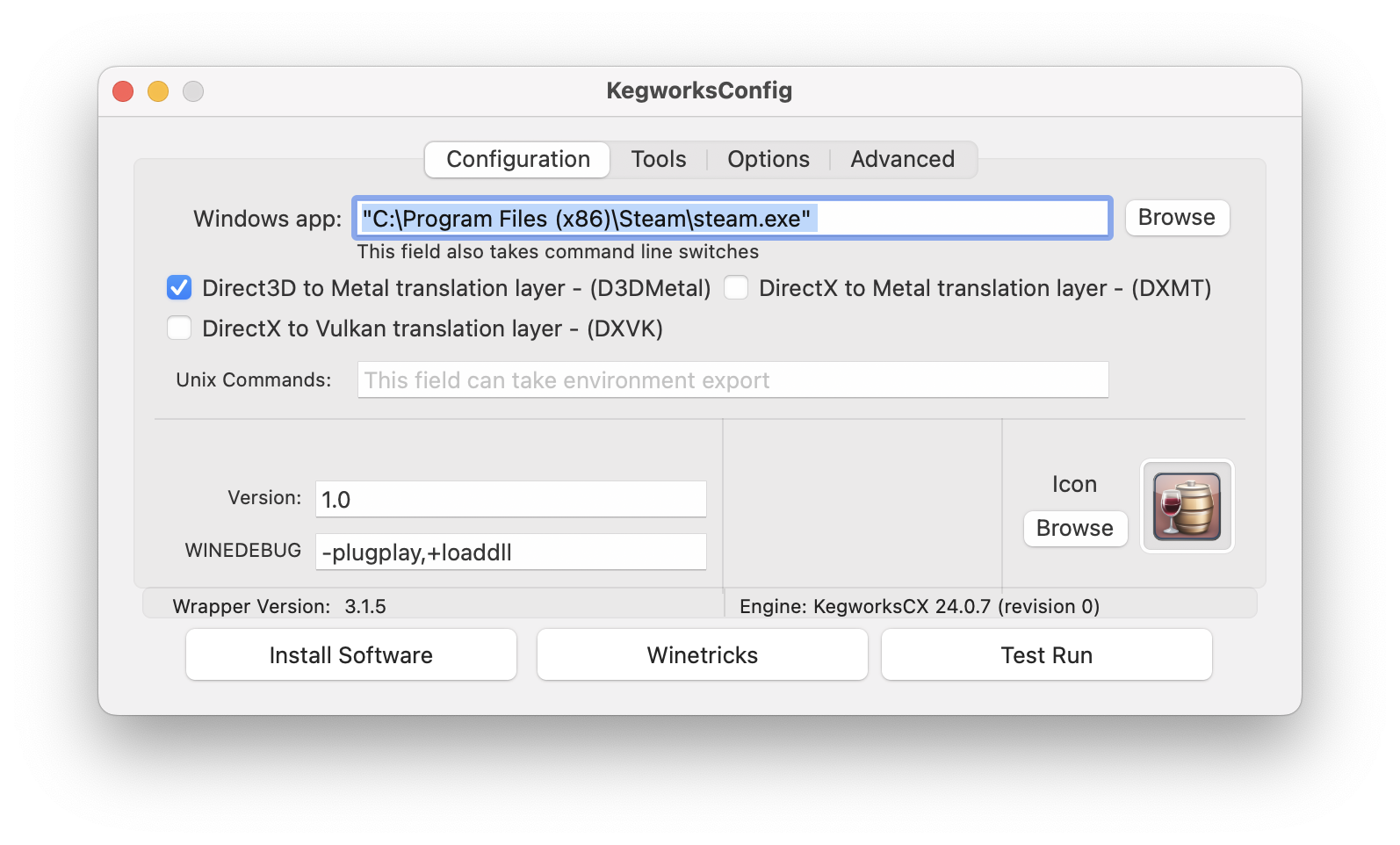

使ってる環境

- macOS Sequoia

- vscode

- git 2.39.5 (Apple Git-154)

- rustc 1.83.0 (90b35a623 2024-11-26)

- cargo 1.83.0 (5ffbef321 2024-10-29)

- github

詳しく説明しないこと

- unixのコマンド(もしくはpwsh,cmdのコマンド)

無駄に詳しく説明すること

- rustの知識(ある意味rust布教記事でもある)

commit: cargo initを実行

開発環境をセットアップして、最初のコミットをしよう。

localリポジトリをセットアップ

rustのプロジェクトを作ります。 とりあえずディレクトリを作成してそこに移動

cargo init .

を実行すると、いい感じにセットアップしてくれます。

.

├── Cargo.toml

└── src

└── main.rs

この時点ですでに、gitのローカルリポジトリがセットアップされています。

補足

cargoというのは、rust開発者を支援するツールです。 rust以外だと、cmake(c言語)、gradle(Java,Kotlin)、npm(nodejs)などがあります。

これらのツールは基本的に、外部ライブラリの整理(インストール)、ビルド支援(プログラム間の連携)をしてくれるわけです。

githubにアクセスできるようにする

github上にリポジトリを作りましょう。

git remote add

する方法もあり、学びとしてはそっちの方が深いのですが、

正直こっちの方が楽

https://cli.github.com

一度githubのアカウントを作成しておけば、CLI上でログインするだけでgithubの機能をコマンド上からアクセス可能です。

sshの鍵登録も不要!

インストール後、

gh auth login --web

コマンドでgithubにログインします。

githubにリポジトリを登録

一度ghコマンドを使えるようにすると、以降次の手順でgithubにリポジトリを作成可能です。

gh repo create

対話式で様々な質問が出てきます。

What would you like to do?

一番最初の質問で三択出てきますが

Push an existing local repository to GitHub

(存在しているローカルリポジトリを、githubにpushする) を選択します。

その後はenter連打でいけます。

注意

Visibility をprivateにすると、非公開になります。 公開するのが怖い場合は注意してください。

コミットする

ここまできたらコミットします。

コミットって何?

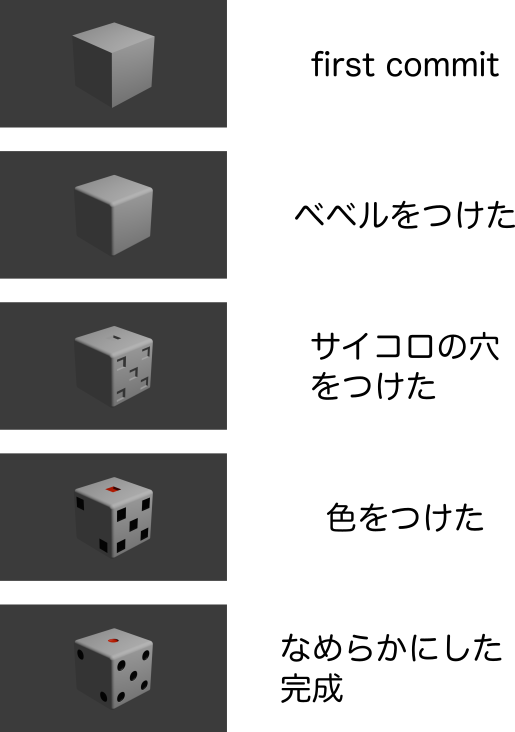

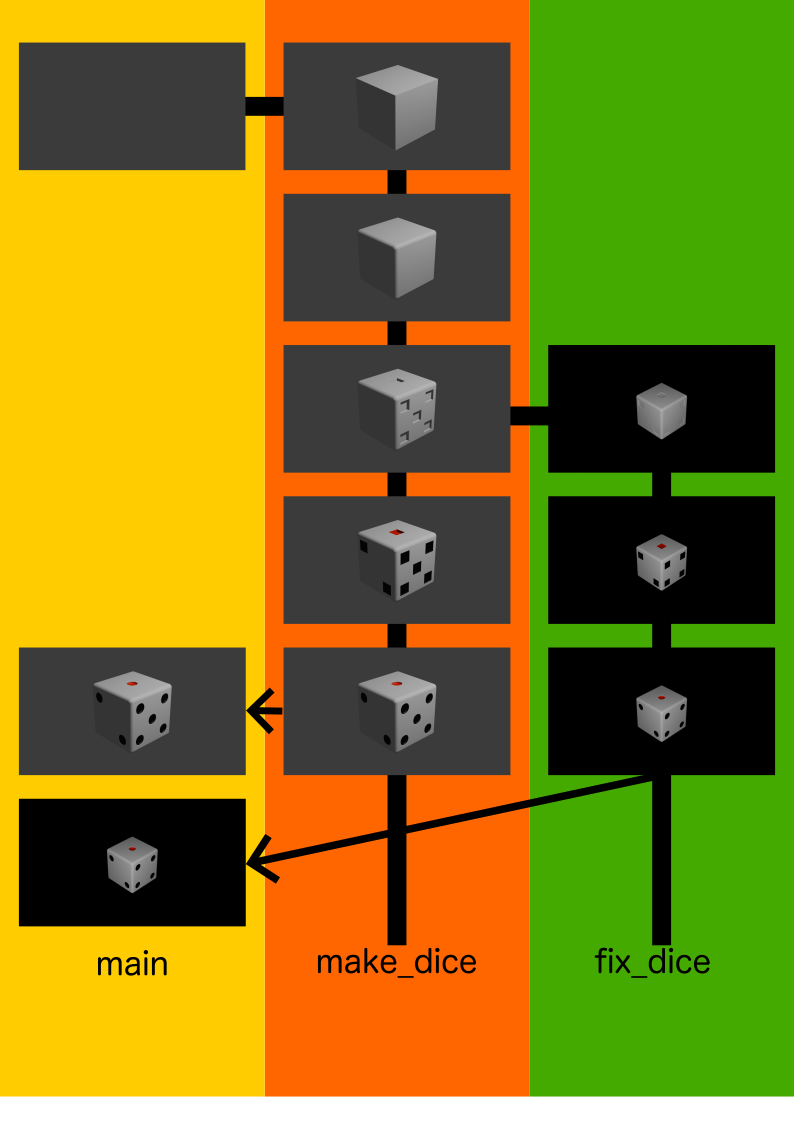

例えば、blenderでサイコロを作るとき...

上からステップごとに分かれていて、作業ステップが変わる度に

git commmit -m <ここにコミットメッセージ>

というコマンドを入力します。

こうすることで、ファイルをいじった時、ファイルの変更にメッセージをつけて記録しておくことができます。

コミット頻度はどうしよう

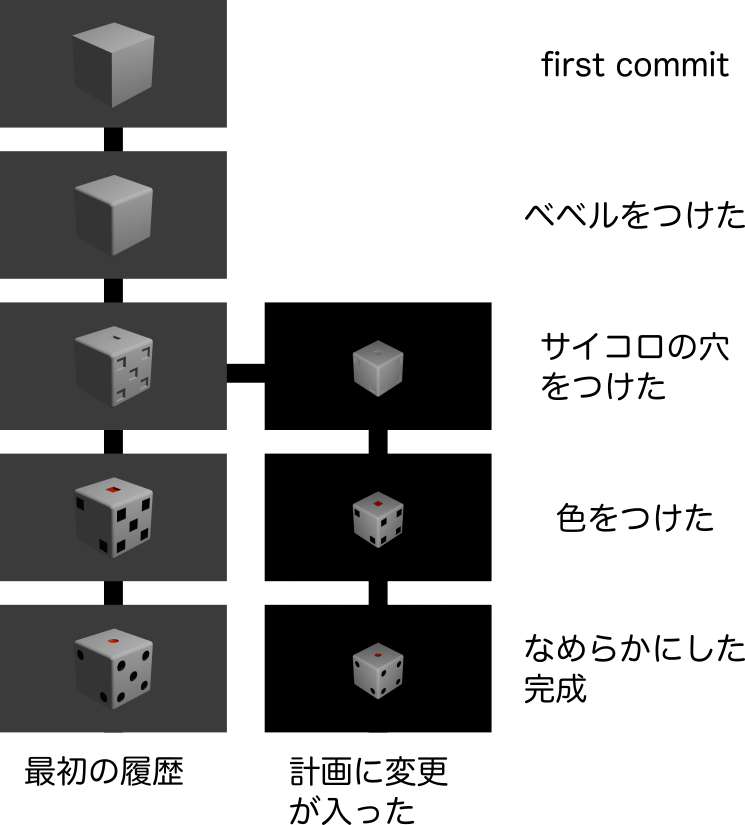

例えば、サイコロの形に変更が入った時...

git logをたとって、あるコミットから分岐させることが可能になります。

(分岐の方法については後で記載します)

そう考えると、次の考え方ができます。

- コミット間に加えた変化が多いほど、戻しづらくなる

- しかし、コミットが多いほど、今度はログが見辛くなる

(例えば、サイコロの穴を開ける時、穴一つ一つ毎にコミットすれば、20コミット増えます)

しかも、git logした時、得られる情報はメッセージのみです。

そう考えると、

- コミットメッセージは丁寧にした方が良い

となるわけです。

コミットの頻度についてはこれらの記事が参考になると思います。

...参考にしてるのかよく分からないですが、 今回は 「変更が一行で説明できる範囲内で1コミット」 を目標に 頑張ります。

ところで

もちろんblenderでもgitは使えます。(blenderにターミナルついてないから相性は良くないかもだけど) 何なら、パワポ、ワード、エクセルといった3種の仁義、 その他etc...

gitのメリットの一つ バイナリファイルが扱える です。

(この記事も下敷きはgit使ってます)

実際に行ってみる

実際にコミットします。

まずはプロジェクトの一番浅いところで次のコマンドを実行

git add .

意味は次の章で説明

git commit -m "cargo initを実行"

これでコミットができます。

first commit? 邪道です、ちゃんとやったことを書く

(こだわり強く生きる)

リモートにあげる

コミットしただけではリモート(github)に適用されません。

次のコマンドでリモートにアップロードできます。

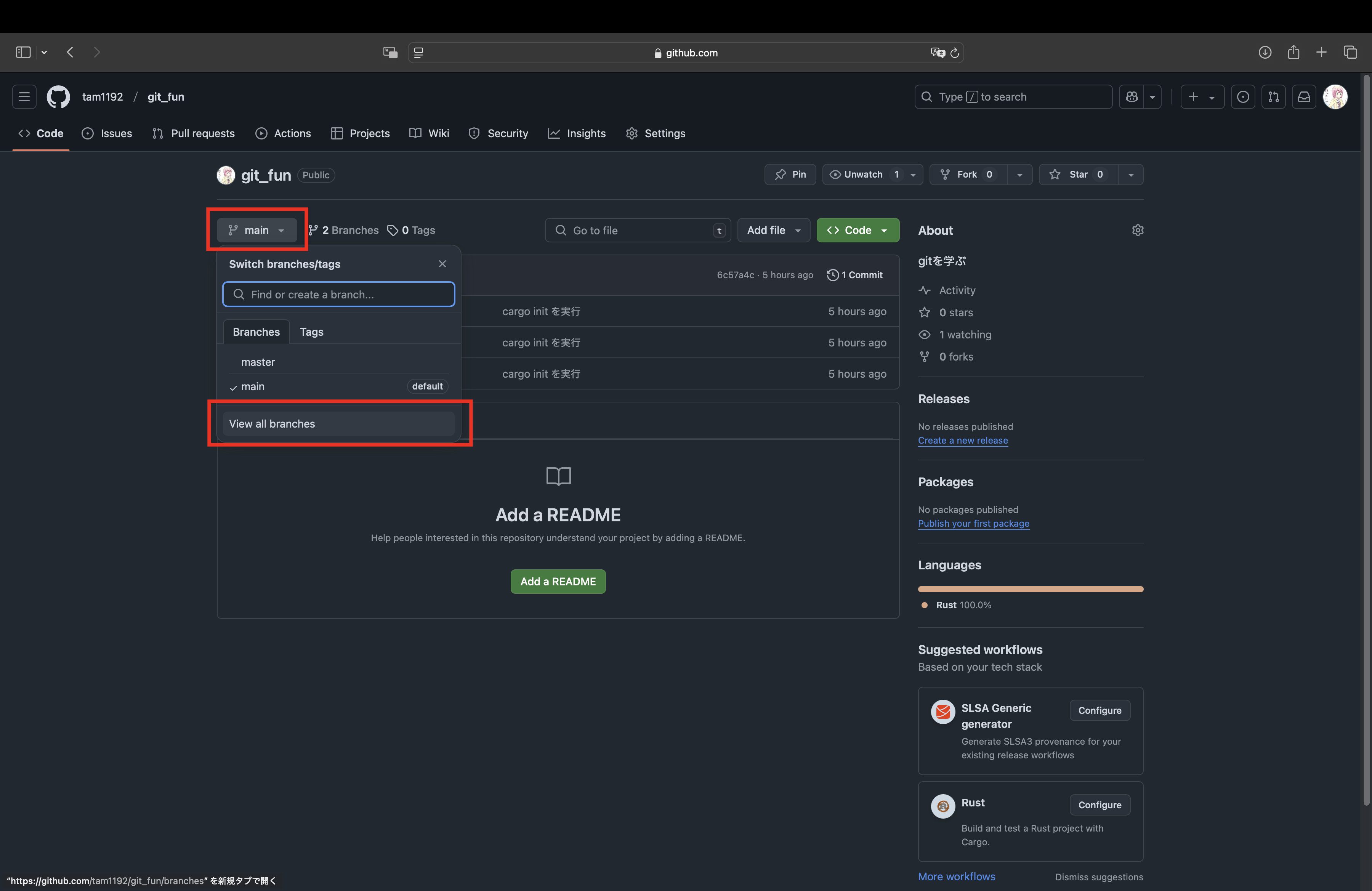

まず、git branchを実行。

このコマンドで表示された文字列がmasterなら

git push --set-upstream origin master

このコマンドで表示された文字列がmainなら

git push --set-upstream origin main

意味は後述

二回目以降はこちら 、理由は後述

git push

logを確認

> git log

commit 6c57a4c498b7a817265563bb8e1c8b31ee1a3a7d (HEAD -> master, origin/master)

Author: nikki9750 <76221172+tam1192@users.noreply.github.com>

Date: Sat Jan 11 17:42:06 2025 +0900

cargo init を実行

commitの後ろに書いてあるハッシュみたいな文字列はコミットハッシュです。 識別子。 さっきみたいにコミット戻す時に使います。

HEADは頭。 今触っているところ。master(main)はブランチと言います。originはリモートの名前です。Authorコミットした人Dateコミットした日付

これで最初の作業は終了です。

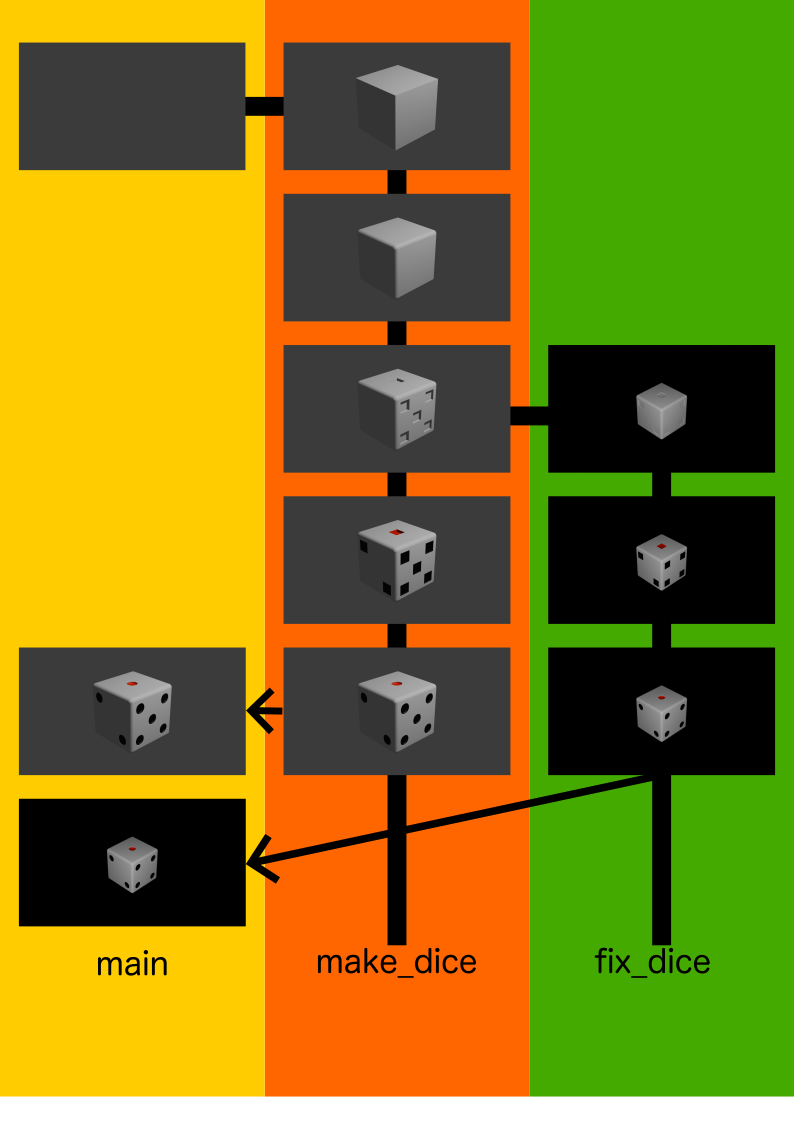

ブランチ

図のように、ログを切り分けることができます。

左から右に、ブランチを作成しています。(ブランチを切るという)

右から左の矢印は、切ったブランチから変更を適用しています。

図のように、ログを切り分けることができます。

左から右に、ブランチを作成しています。(ブランチを切るという)

右から左の矢印は、切ったブランチから変更を適用しています。

一度作成したブランチは消すまで存在し続けます。 別のブランチで加えた変更は、様々な方法で別のブランチで適用ができます。

ブランチのメリットは、触りながら理解できればいいかなと思います。

mainとmaster(変更は任意)

masterが差別用語に該当するとかで、mainという言い方に切り替わっています。(参考)

masterブランチは、これ以降mainに統一して説明します。

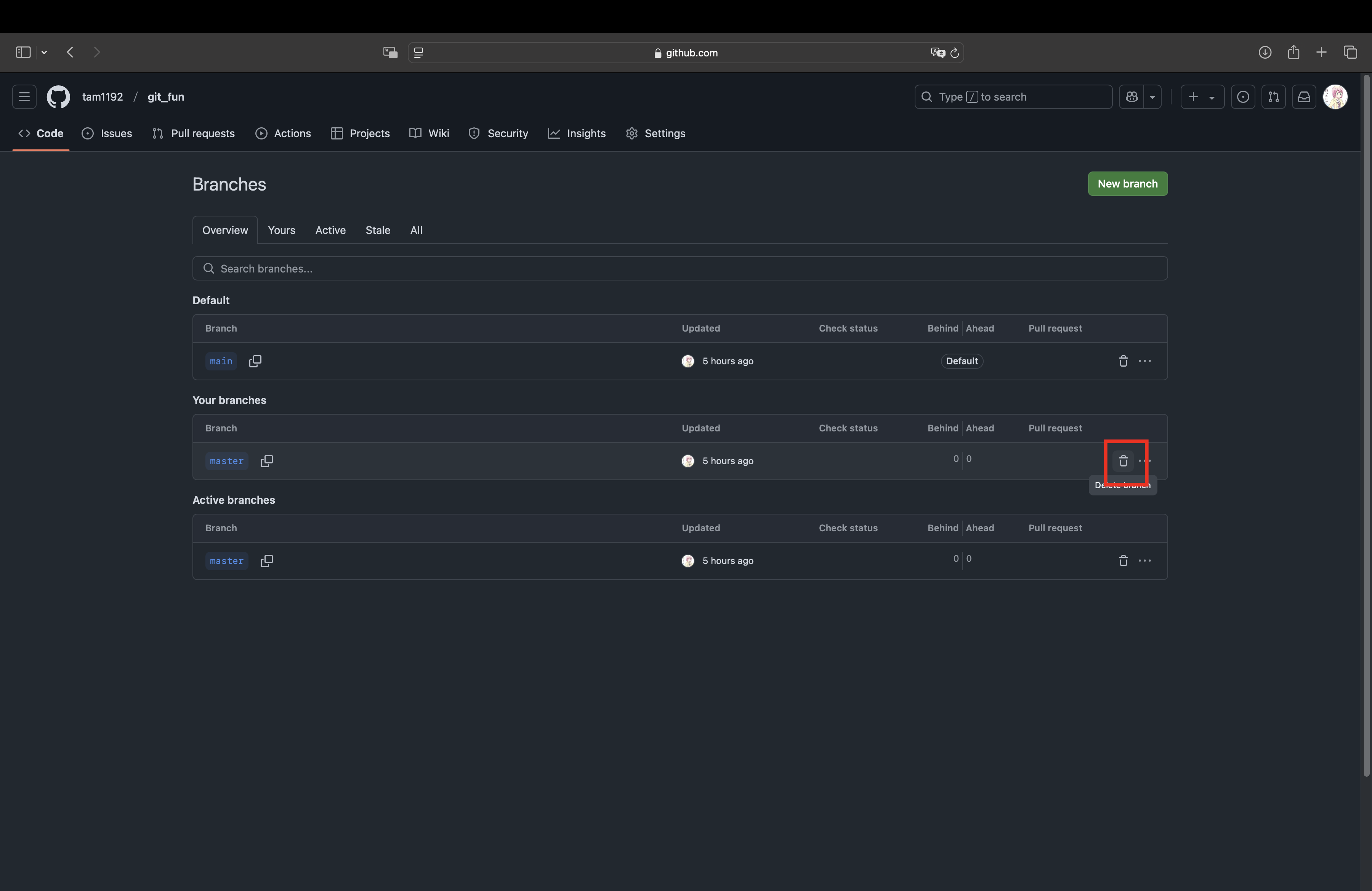

私の環境では、cargoが生成するgitリポジトリのデフォルトブランチが"master"なので、gitに触れるついでに変更しておきます。

今いるブランチをmasterにして、

git branch -m main

で変更。

-mはブランチ名の変更を意味するそう。

そのままpushしようとすると

fatal: The upstream branch of your current branch does not match

the name of your current branch. To push to the upstream branch

on the remote, use

git push origin HEAD:master

To push to the branch of the same name on the remote, use

git push origin HEAD

To choose either option permanently, see push.default in 'git help config'.

To avoid automatically configuring an upstream branch when its name

won't match the local branch, see option 'simple' of branch.autoSetupMerge

in 'git help config'.

と出るので、その通りに

git push origin HEAD

しかし、リモート側に新規作成されるだけで、変更にはならないので...

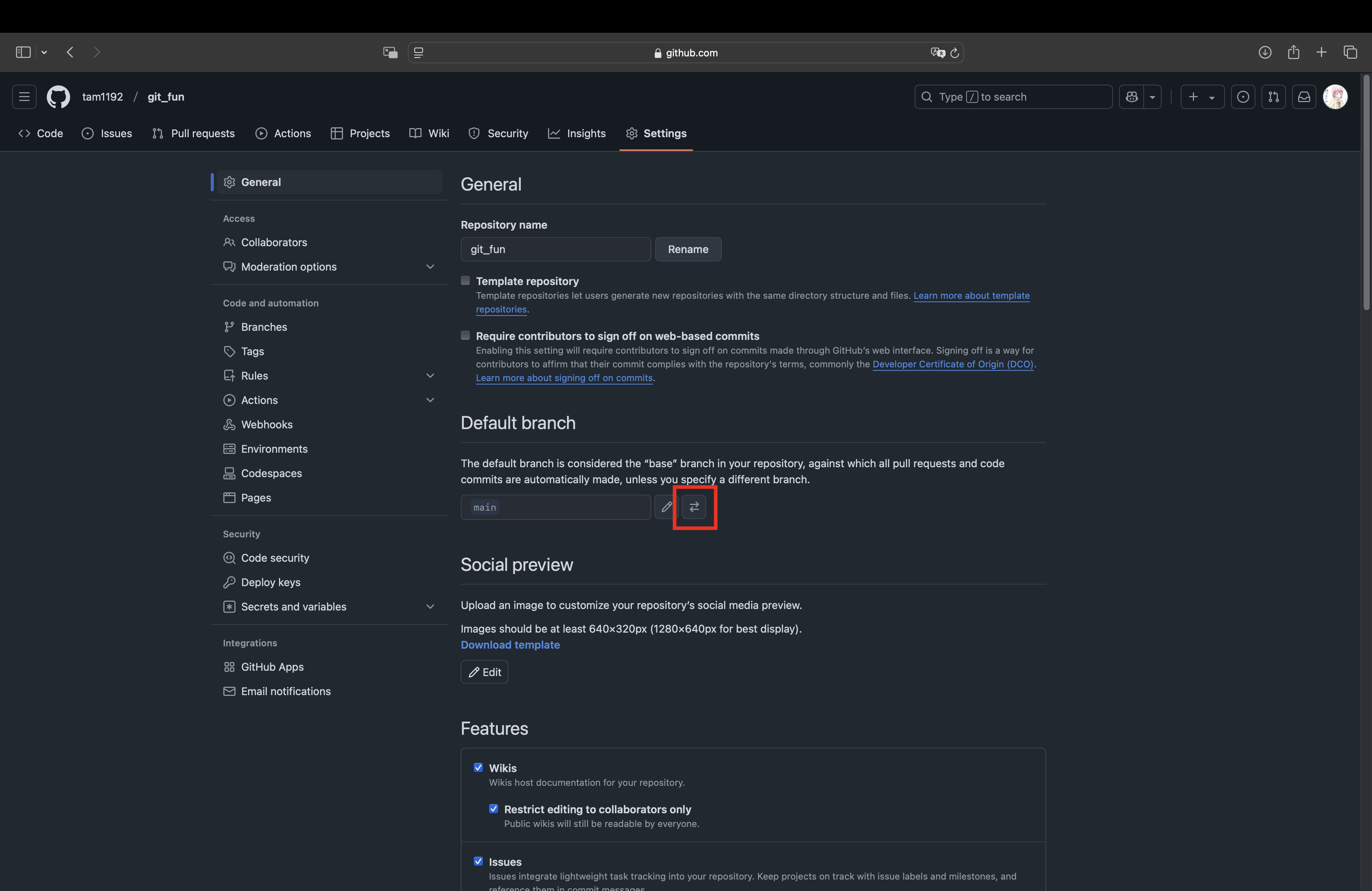

githubのSettingsにアクセスし

githubのSettingsにアクセスし

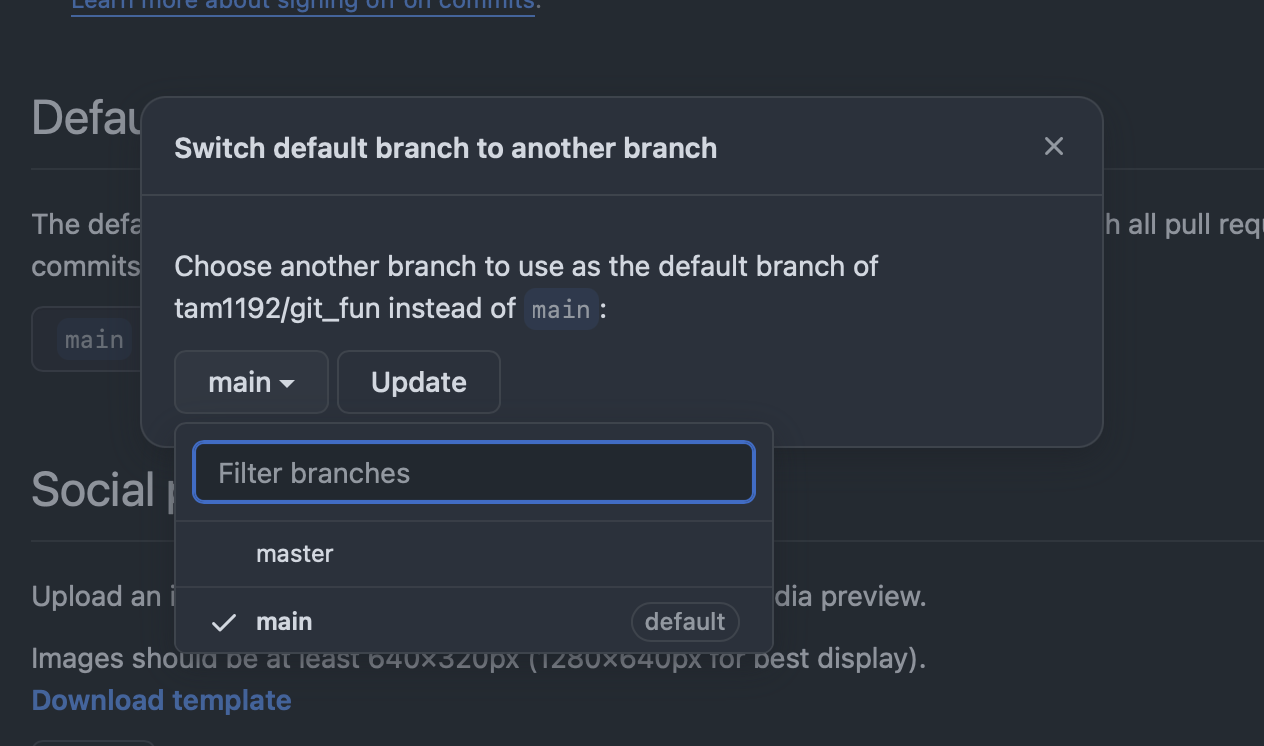

Default branchを変更

Default branchを変更

その後、masterブランチを削除する

その後、masterブランチを削除する

これで解決...しない ローカルの方でも変更が必要。

> git branch -a

* main

remotes/origin/main

remotes/origin/master

-aオプションは、隠しブランチ的な存在を表示してくれる。

remoteというのはその名通りリモートのこと。

リモートとローカルは、その性質上ズレが生じる。それをうまいこと解決してくれるブランチなのだが、masterが居残る。

git fetch --prune

を実行すると、masterが消えてくれる

> git branch -a

* main

remotes/origin/main

remotes/origin/master

試してないから知らんが、git branch -d /remotes/origin/masterよりは安全と見た。

branch: ライブラリを試験

日記さんはコマンドラインプログラムを書くことに決めました。

計画を練ろう

計画的に開発する方が、幸せになります。 (ちなみにこの記事は無計画です。)

コマンド名はnanodesuにします。

nanodesuは、nanoコマンドをめっちゃシンプルにしたテキストエディターです。

大まかな計画はこんな感じ

- 引数処理: 引数の処理をします

- ファイル入出力処理: ファイル読み込みの処理をします

- キー処理: コマンド実行中に受けた入力に応答します

- 画面処理: 入力に対応して画面が動くようになります

- デプロイ: 公開します。

- ドキュメント作成: 説明書を作ります。

使うライブラリを検討

一から書くと時間がかかります。 有志が作ってくれた優秀なライブラリをフル活用しましょう。

- clap: 引数の処理をしてくれます

- ratatui: 画面の処理とキー処理を担当してくれます

- fs: ファイルの処理をしてくれます

この先の計画を練る前に

ライブラリを使う場合、まずは触れてみたくなります。 触れるために新しいプロジェクトを作っても良いのですが、 せっかくgitを使ってるので 、gitで管理しようではありませんか。

ブランチを作る

この図のように、コミットログを切り替えることができます。

この図のように、コミットログを切り替えることができます。

左から右に、ブランチを作成しています。(ブランチを切るという)

git checkout -b <ブランチ名>

でブランチを切ることができます。 ここで加えた変更は、mainには適用されません。

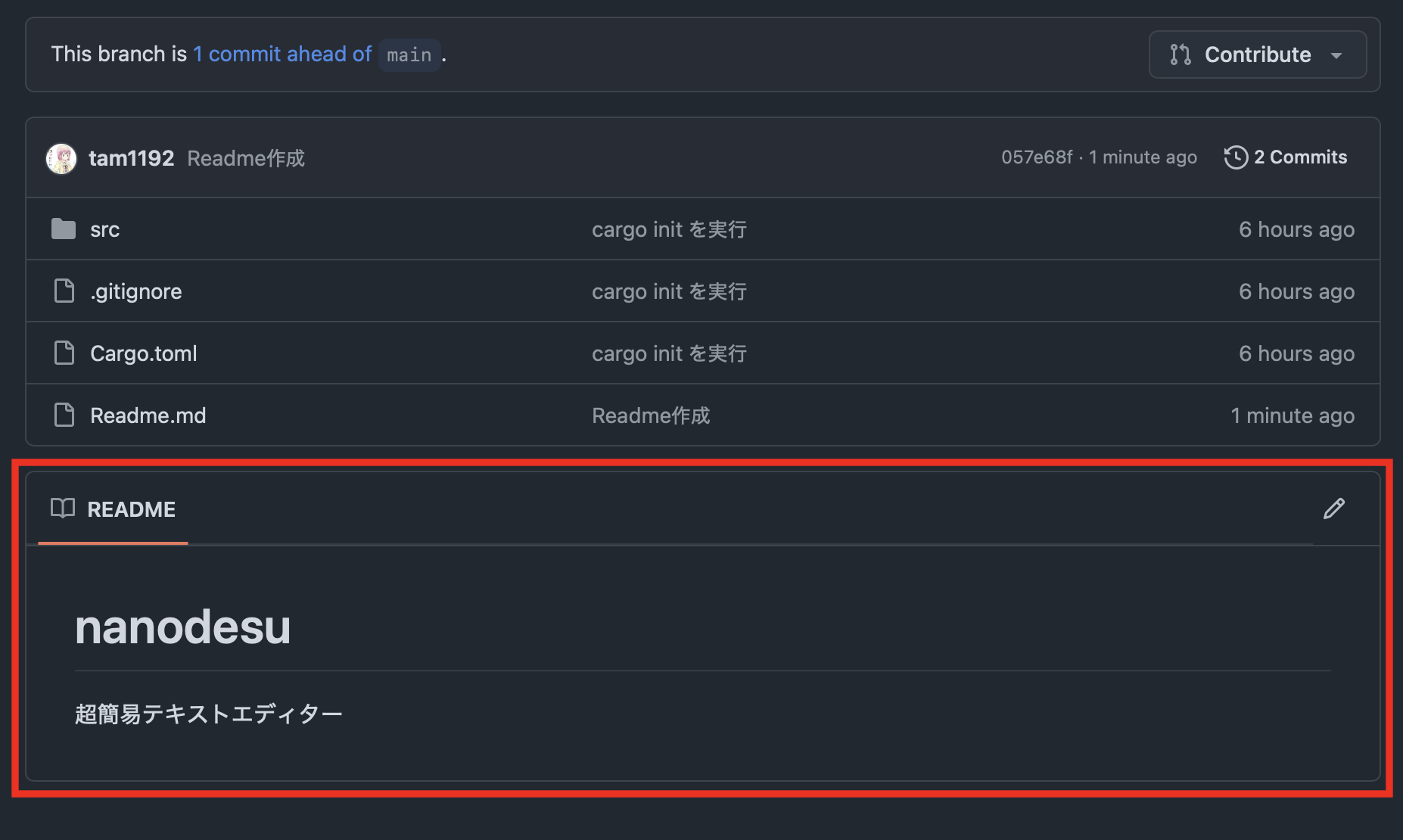

Readmeファイルを追加しよう

Githubでは、Readme.mdというマークダウンファイルがある場合

この部分に、その内容が表示されます。

この部分に、その内容が表示されます。

このファイルをブランチを使って追加してみましょう。

git checkout -b Readme追加

ブランチが作成されると

git branch

を実行した時に

> git branch

* Readme追加

main

となるはずです。 *が今作業しているブランチ。

内容は適当でいいので、Readme.mdを作成して保存。 コミットはまだしないでください。

ブランチを切り替える

git checkout main

で一度mainに戻ります。

lsコマンドで中身を除くとこうなるはずです。

> ls

Cargo.toml Readme.md src

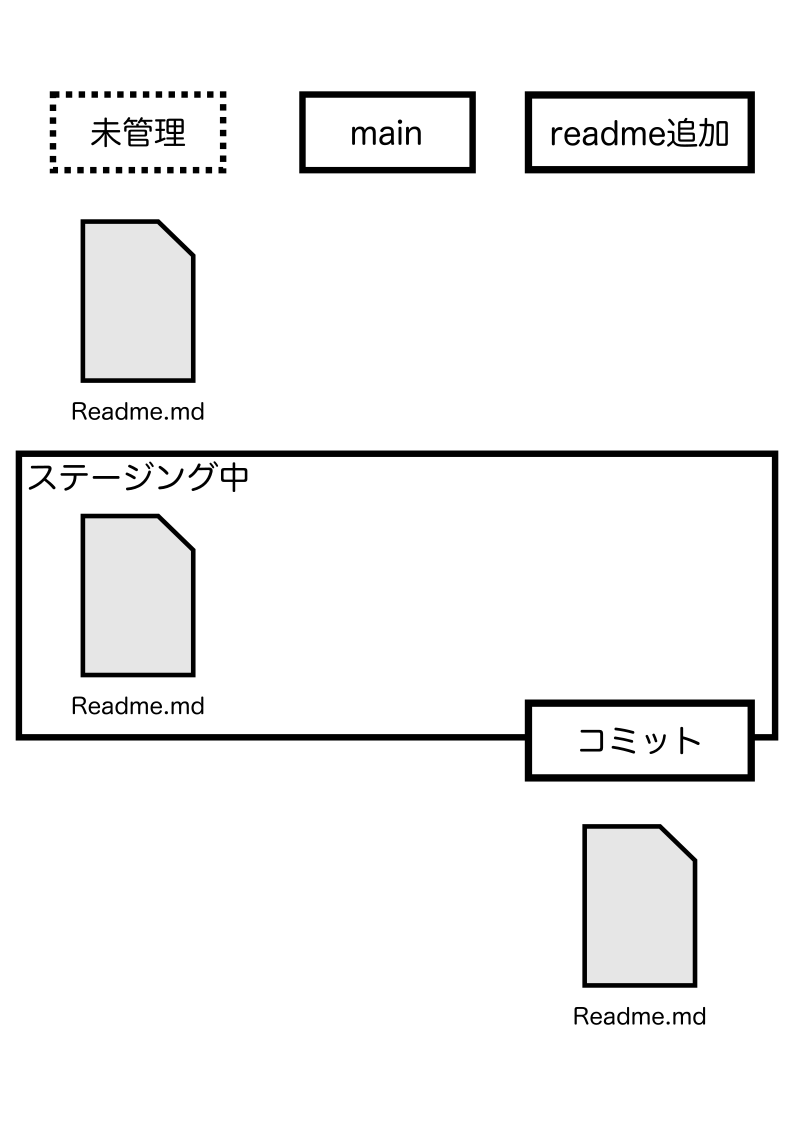

ブランチをせっかく分けたのに、変更がmainにも同時に適用されているように見えます。

この時点で、Readme.mdがまだgitの管理下にない状態であることを理解する必要があります。 コミットもしてないから当然っちゃ当然?

ステージング

git checkout Readme追加

で先ほどのブランチの戻ります。

git addは、コミットするファイルをステージングするためのコマンドです。

git addは、前回のコミットから変更が加えられたファイルのみをステージングします。

git add .で、カレントディレクトリーより深く変更が加えられたファイル全てをステージングに追加します。

git addの恩恵はこの先で知ることができるはずです。

git add .

もしくは

git add Readme.md

でステージングします。

git checkout main

でもう一度mainに戻ります。

lsコマンドで中身を除くとこうなるはずです。

> ls

Cargo.toml Readme.md src

ステージングした時点ではまだコミットされていません

コミットするブランチを決める

この状態でgit commitをすると、mainブランチでコミットされます。

それだと困るので、

git checkout Readme追加

で先ほどのブランチの戻ります。

git commit -m Readme追加

ついでにremoteにあげましょう。

remoteとorigin

git remote -v

を実行すると

> git remote -v

origin https://github.com/tam1192/git_fun.git (fetch)

origin https://github.com/tam1192/git_fun.git (push)

となるはずです。 -vは`verboseの略で、冗長とかいう意味があります。

originとなってますが、名前を変更できます。

git remote rename origin github

もう一度実行すると

git remote -v

github https://github.com/tam1192/git_fun.git (fetch)

github https://github.com/tam1192/git_fun.git (push)

名前が変わっています。 gitは複数のリモートリポジトリを同時に管理可能なため、remoteを自由に追加できます。 originとは初期設定でつくremoteサーバーの識別名です。

複数のremoteを使えるのは、gitが分散型だからとも言えるのではないでしょうか。 しらんけど

だけど、基本一つのremoteしか使いたくない(複雑になるから)

リモートにブランチを作る

gitの分散というのは何も、複数のリモートを使えるということだけではありません。 リモートリポジトリの内容がローカルリポジトリに丸まるクローンされているというのも大きいです。

だからこそ、今作ったブランチがリモートに存在するとは限らないのです。

git pushとは何者か

git pushを実行すると、ブランチごとにあらかじめ設定しておいたリモートのブランチに、変更を送信します

set-upstreamでリモート

実際にリモートにブランチを作るにはこう設定します

git push --set-upstream <リモートの識別名> <リモートでのブランチ名>

なお、基本的にローカルとリモートのブランチ名は同一です。

git push --set-upstream origin Readme追加

※originをgithubに変えた場合は変更してください。

これで、リモートに変更が加えられます。

一度設定したら再び同じことをする必要はありません。

git pushだけで送信されます。

mainに変更を適用する

コミットが成功するとmainブランチで

> ls

Cargo.toml src

という結果が得られるはずです。

Readme.mdはReadme追加ブランチで変更を保存されたため、mainには存在しない扱いに切り替わったのです。

gitがまだ一度もコミットしたことがない、未管理のファイルはコミットするまで全てのブランチで表示されます。

gitがまだ一度もコミットしたことがない、未管理のファイルはコミットするまで全てのブランチで表示されます。

gitがファイルを操作していないからです。

一方で、コミットすると、コミット履歴が残っているブランチにのみファイルが存在するようになります。

gitがファイルを操作するようになるからです。

現時点でmainブランチにReadme.mdが作成された履歴がないから、表示されないわけです。

参考URLとか

感想もうっすら書いてます。割と適当なので注意されたし

作図・図とか

この際だからblender触ってみたかった。 最新版でもイケる

git

コミット頻度関係

頻繁にコミットするのが大切らしい

適度なコミットがよいらしい

便利だなぁ。是非ともブックマークしたい記事

ブランチ

-nではなく-mなのか。 変更することないから知らんかった。

追跡ブランチってちょっと複雑だから使わないように気をつけて書いてた。

rust関係

Crate

Vue × WASM × Rust—試行錯誤とこれからの展望

初版投稿日: 2025/06/10 (コミット履歴より) 更新日: 2025/09/05

元々 AI 一緒に書いた記事ですが、少し改めます。

本日のふたこと

(2025/09/05 のひとことになります)

すでに別記事をあげてるので二言目になります。

最近ずっと聴いてる

とりあえず

このサイトは、rust(nom)で書かれた四則演算パーサーを wasm で載せ、それを実際に動かしているものです。 nom などについては当サイトのパーサー記事が参考になるかと。

wasm の注目度

私が思っていたより、wasm はすごいものでした。 Linux コンテナの「次」としての WebAssembly、の解説

なんとコンテナの「次」なんですね!

これは驚いた。あんま深く考えてなかったから、共存ぐらいにしか思ってなかった。

wasm と java の違い

kotlin という rust の次に好きな言語のおかげで、java の抵抗も減ってます。

しかし、GC に抵抗ある人にとっては結構いい選択肢になると思います。

(あと java のバージョンかんりめんどくさい)

まとめ

詳しいことかつ当時の背景については、AI と一緒に書いた旧記事の項目を開いてみてみてください。

AIと一緒に描いた旧記事

最近、Vue や Nuxt、Nuxt UI を触れていて、「色々作れそうだな」と思うことが増えてきました。

一方で、JS の型システムがガバガバすぎて、Rust が恋しくなってきました。

そこで、WASM の存在を思い出し、Rust の強みを活かせる仕組みを急遽作ることにしました。

experiments-wasm-vue について

このリポジトリでは、Rust を WASM としてコンパイルし、Vue と連携する試みを行いました。

内容としてはシンプルで、BMP パーサーを作る際にお世話になった nom を活用し、四則演算パーサーを作ったものです。

当初、外部ライブラリを使うと WASM のコンパイルが難しいかと思っていましたが、入出力が絡まない処理なら問題なく通ることが分かりました。

LLVM が適切に変換してくれるらしく、「まじか…?」と驚きつつも、その柔軟さに感動しました。

リポジトリのリンク:

Vue の環境構築と WASM の連携

Vue の開発環境は Vite を使ってセットアップしました。 そのため、通常の Vue 開発とは少し異なり、Vite の設定にも気を配る必要がある点がポイントになります。

また、今後は Nuxt への連携も視野に入れているのですが、ここで引っ掛かったのが WASM を Node.js のモジュールではなく、Web サイトとして使える形式にビルドすることでした。

どーやら通常の HTML 同様の紐付け方をすれば OK らしい?ということが分かったので、今回はそうしました。

Nuxt のディレクトリ構造と WASM の管理方法

Nuxt4 から、主要なコンポーネントのディレクトリが/app に集約されるようになるそう。 なので、同じプロジェクト内で/wasm ディレクトリを作り、WASM のコードを管理するのが良さそうだと考えています。

まだ検証の余地はありますが、この方法なら Vue/Nuxt のコンポーネントと適切に連携できそうなので、今後試していきたいと思います。

今後の展望—ランタイムの構想

WASM の可能性を探る中で、「Web ブラウザ上で動く独自ランタイムを作ってみたい」とも考え始めました。

カーネルレベルの設計とまではいきませんが、例えば:

- ブラウザ内で動く軽量な仮想環境

- WASM の能力をフル活用できる処理オフロード

- Rust の型安全性を生かしたスクリプト実行システム

こういうの作ってみたいなって願望を持ってます。願望です。はい。

まとめ

wasm はいいぞ

参考など

- Vue ベースな Web ツールのロジック部分を Rust 製 Wasm で実装する: pirosuke 様

ディレクトリの構造等を参考にしました。 - Rust から WebAssembly にコンパイル/mdn

いつも通りめっちゃわかりやすい

なんで更新したの

リポジトリを綺麗にした記念です。 orphan ブランチ作って cherry-pick しまくり、main ブランチを完全に作り直しました。 また、まだ動かないコミットは dev ブランチに移動し、動作するようにさせました!

当時の記事にはmain コミットいじって動かなくなっちゃった!thprって書いてあって腹が立ったので描き直しました。

当時の自分に切れる

自分の敵は自分っちゅーことや

イケてる tui を作ってみる part1

tui: gui ではないが、コマンドラインで操作できる ui のこと

🎵 本日の一曲

ぎゅうたんたん

とりあえず一句

extern crate crossterm; use std::io::{Result, stdout}; use crossterm::{ExecutableCommand, cursor::MoveDown, execute, style::Print}; fn main() -> Result<()> { stdout() .execute(MoveDown(4))? .execute(Print("hello world"))?; Ok(()) }

Finished `dev` profile [unoptimized + debuginfo] target(s) in 0.06s

Running `target/debug/train_signal_sim`

hello world

行列自由に扱えるようになりますね。

queue について

extern crate crossterm; use std::{ io::{Result, Write, stdout}, thread::sleep, time::Duration, }; use crossterm::{QueueableCommand, style::Print}; fn main() -> Result<()> { let mut stdout = stdout(); stdout.queue(Print("hello\n"))?; sleep(Duration::from_secs(1)); stdout.queue(Print("world\n"))?; stdout.flush() }

1 秒経って

hello

world

と表示されると思っていた

実際には hello と表示された後に 1 秒待機になったで。

改行\nを抜いてみた

extern crate crossterm; use std::{ io::{Result, Write, stdout}, thread::sleep, time::Duration, }; use crossterm::{QueueableCommand, style::Print}; fn main() -> Result<()> { let mut stdout = stdout(); stdout.queue(Print("hello"))?; sleep(Duration::from_secs(1)); stdout.queue(Print("world"))?; stdout.flush()?; Ok(()) }

想定通り、1 秒経った後にhelloworldが表示された。

movedown で改行しよう

extern crate crossterm; use std::{ io::{Result, Write, stdout}, thread::sleep, time::Duration, }; use crossterm::{QueueableCommand, cursor::MoveDown, queue, style::Print}; fn main() -> Result<()> { let mut stdout = stdout(); queue!(stdout, Print("hello"), MoveDown(1))?; sleep(Duration::from_secs(1)); queue!(stdout, Print("world"), MoveDown(1))?; stdout.flush()?; Ok(()) }

hello

world

私はそんなスタイリッシュなのを求めていない。

movetonextline で改行しよう

extern crate crossterm; use std::{ io::{Result, Write, stdout}, thread::sleep, time::Duration, }; use crossterm::{cursor::MoveToNextLine, queue, style::Print}; fn main() -> Result<()> { let mut stdout = stdout(); queue!(stdout, Print("hello"), MoveToNextLine(1))?; sleep(Duration::from_secs(1)); queue!(stdout, Print("world"), MoveToNextLine(1))?; stdout.flush()?; Ok(()) }

hello

world

想定通りに動作したね。

m さんみたいなやつ

#?#

#?#?#

o

|

###################################

これを書いてみよう。

use std::{ io::{Result, Write, stdout}, thread::sleep, time::Duration, }; use crossterm::{ cursor::{MoveTo, MoveToNextLine}, queue, style::Print, terminal::{Clear, ClearType, size}, }; fn main() -> Result<()> { let mut stdout = stdout(); // 画面を初期化 queue!(stdout, Clear(ClearType::All))?; // サイズを確認する // 左上を1としてスタート // https://docs.rs/crossterm/latest/crossterm/terminal/fn.size.html let (col, row) = size()?; // 床の描画 for c in 0..col { queue!(stdout, MoveTo(c, row), Print("#"))?; } stdout.flush()?; Ok(()) }

とりあえず床だけ描画してみることにした。

#######################

イケてる tui を作ってみる part2

今回は標準入力を試してみます

🎵 本日の一曲

たまたま目に入ったので

百合注意

やっぱ琴葉姉妹百合最高だよな

...

リアルタイムで標準入力を受け取ってみよう

こんなかんじ

use std::{

io::{Result, Write, stdin, stdout},

thread::sleep,

time::Duration,

};

use crossterm::{

cursor::{MoveTo, MoveToNextLine},

event::{

EnableBracketedPaste, EnableFocusChange, EnableMouseCapture, Event, KeyEvent,

KeyboardEnhancementFlags, PopKeyboardEnhancementFlags, PushKeyboardEnhancementFlags, poll,

read,

},

execute, queue,

style::Print,

terminal::{Clear, ClearType, enable_raw_mode, size},

};

fn main() -> Result<()> {

// 色々な機能を無効にする

_ = enable_raw_mode();

// printlnなどの動作がおかしくなるので、crosstermの関数を使うようにする。

let mut stdout = stdout();

loop {

// 入力イベントの処理

if poll(Duration::from_millis(100))? {

if let Event::Key(event) = read()? {

execute!(stdout, MoveTo(0, 0), Print(format!("{:?}", event)))?

}

}

}

}とりあえずキーイベント only

KeyEvent {

code: Char('a'),

modifiers: KeyModifiers(0x0),

kind: Press,

state: KeyEventState(0x0)

}こんな感じの構造体が event の中に入ってる。

note

raw モードにしないと、enter を受け取るまで入力を待機してしまう

note

poll 関数を挟むと、(上記の例だと)100ms まって入力がなければ、false を返す(=イベントの処理をスキップする)

イベント楽しい

main 関数に設置した loop 文で、入力、処理、出力を繰り返す。 これを応用すると、ゲームとか作れる

おわり

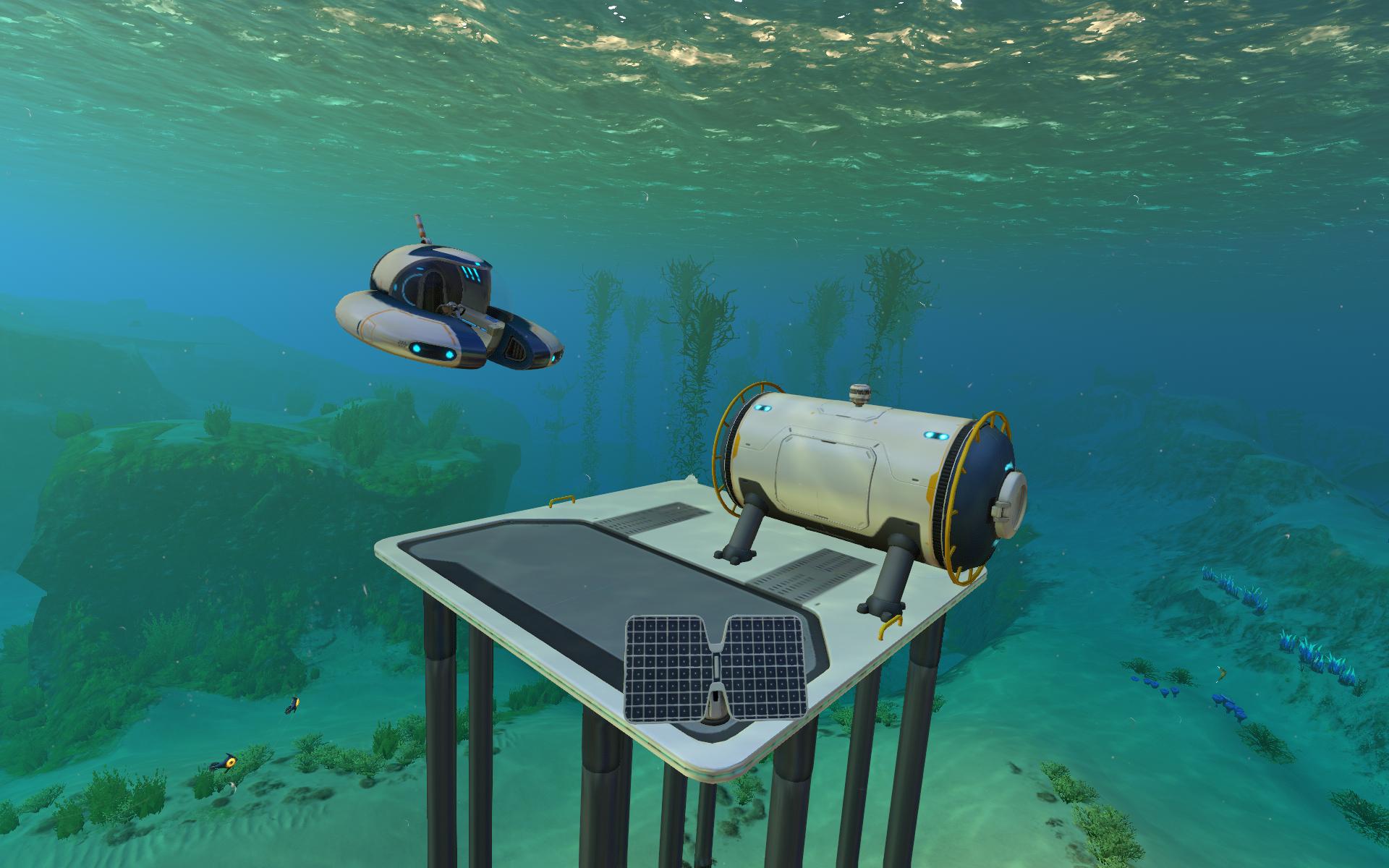

subnautica、シーモス食われました。

資材集め大変です。

構造体で遊ぶ

この記事を書いた理由って必要ですか。

特に構造体推しでもないし、ネタ切れではあるけど、少しまとめとこと思っただけで理由って必要ですか。

(オリ曲のサビから抽出)

本日の一本

曲ストックが切れたので、次は動画でも共有しようかと思った。

これ本当草

(twitter の引用 RT かよ)

まず普通に定義する

classDiagram

class Point {

- usize x

- usize y

}

この UML の通りに構造体を定義してみます

struct Point { x: usize, y: usize, } fn main() { let p = Point { x: 3, y: 6 }; println!("{}", p); }

実行すりゃ破るけど、これだと普通にエラーになるわけで。

こいつは表示機能を持ってないからね。もしくは、println で表示する免許を持ってない。

Point 構造体に(とりあえず)Debugトレイトを実装しよう。

note

これを書いている頃の日記さんは、trait を免許とたとえてもいいんじゃないかという困ったどうでもいい考えを持ってます。

tip

実行すれば、コンパイルエラーと表示されるはずです。 (error: could not compile...)

コンパイルエラーは実行ファイルが作られないで発生するエラーです。 よって、コンパイルエラーが含まれているコードからはプログラムが発生しない。

コンパイルエラーは安全なのです。 一方、実行時に発生するエラーは安全ではないエラーです。

rust の安全性の一つは、コンパイルエラーが豊富なことだと感じます。(あくまで感想)

エラーが含まれるコードは、コンパイルの時点で弾いてくれるのでね。

Debug を定義する

classDiagram

direction TB

class Point {

-usize x

-usize y

}

class Debug {

- std::fmt::Result fmt()

}

<<Trait>> Debug

Point --|> Debug

多分こんな感じ

#[derive(Debug)] struct Point { x: usize, y: usize, } fn main() { let p = Point { x: 3, y: 6 }; println!("{:?}", p); }

derive マクロによってほぼ自動的に実装してもらいました。

println!の中身で、{}が{:?}に変わっていることに注意が必要です。

tip

#[]は手続きマクロと呼ばれるものですね。

この記事が詳しいと思います。

一方て、println!()と関数名の後ろに!がついているのは宣言マクロです。

可変長引数に対応する関数が作れます。

note

せっかくなので出力例を、おっと。

この mdbook というやつはコードブロックそのまま実行可能だったんだ。 ▶️ ボタンで実行可能。

文字列変換に対応させ、好きなフォーマットで出力できるようにする

classDiagram

direction TB

class Point {

-usize x

-usize y

}

class Debug {

- std::fmt::Result fmt()

}

<<Trait>> Debug

class Display {

- std::fmt::Result fmt()

}

<<Trait>> Display

Point --|> Debug

Point --|> Display

use std::fmt; #[derive(Debug)] struct Point { x: usize, y: usize, } impl fmt::Display for Point { fn fmt(&self, f: &mut fmt::Formatter<'_>) -> fmt::Result { write!(f, "{}, {}", self.x, self.y) } } fn main() { let p = Point { x: 3, y: 6 }; println!("{}", p); assert_eq!(p.to_string(), String::from("3, 6")); }

Debug と異なり、Display はフォーマットを自分で作りたいので手動です。

Display はto_string()も間接的に実装してくれます ToString トレイトもありますが、Display を使っておけば両方に対応するのです。

write!マクロは println と使い心地が似てますが、先頭に Formatter を指定する必要があります。

ユーザーに自由な値を提供する

usize以外にも、u8でメモリを節約する、i32でプラマイに対応する、f64で小数点に対応させる、&strで文字列を扱うようにするなど、さまざまなユースケースが考えられます。

classDiagram

direction TB

class Point["Point < T >"] {

-T x

-T y

}

class Debug {

- std::fmt::Result fmt()

}

<<Trait>> Debug

class Display {

- std::fmt::Result fmt()

}

<<Trait>> Display

Point --|> Debug

Point --|> Display

use std::fmt; #[derive(Debug)] struct Point<T> { x: T, y: T, } impl<T> fmt::Display for Point<T> { fn fmt(&self, f: &mut fmt::Formatter<'_>) -> fmt::Result { write!(f, "{}, {}", self.x, self.y) } } fn main() { let p = Point { x: 3, y: 6 }; println!("{}", p); assert_eq!(p.to_string(), String::from("3, 6")); }

残念ながらこれでは、コンパイルエラーになります。

問題点は「Display」です。 T が Display(もしくは ToString)を実装しているという確証がないのです。

T が特定のトレイトを実装している時のみ、メソッドの利用を許容する

rust のトレイトは、面白い機能があります。 メンバー変数が実装しているトレイトによって、使用できるメソッドを変化させられるのです!

use std::fmt; #[derive(Debug)] struct Point<T> { x: T, y: T, } impl<T> fmt::Display for Point<T> where T: fmt::Display, { fn fmt(&self, f: &mut fmt::Formatter<'_>) -> fmt::Result { write!(f, "{}, {}", self.x, self.y) } } fn main() { let p = Point { x: 3, y: 6 }; println!("{}", p); assert_eq!(p.to_string(), String::from("3, 6")); }

構造体Pointは、型に制限なく作ることができます。 Display トレイトを実装してなくても、実装できます。

一方で、Point を Display に対応させるためには、型 T に Display トレイトを実装している必要があります。

足し算引き算できるようにする。

数学的なのはおいといて、x と y それぞれ足し引きできるようにします。 Addトレイト、およびSubトレイトです。

use std::{ fmt::{self, Pointer}, ops::{Add, Sub}, }; #[derive(Debug, PartialEq, Clone, Copy)] struct Point<T> { x: T, y: T, } impl<T> fmt::Display for Point<T> where T: fmt::Display, { fn fmt(&self, f: &mut fmt::Formatter<'_>) -> fmt::Result { write!(f, "{}, {}", self.x, self.y) } } impl<T> Add for Point<T> where T: Add<Output = T>, { type Output = Point<T>; fn add(self, rhs: Self) -> Self::Output { let x = self.x + rhs.x; let y = self.y + rhs.y; Point { x, y } } } impl<T> Sub for Point<T> where T: Sub<Output = T>, { type Output = Point<T>; fn sub(self, rhs: Self) -> Self::Output { let x = self.x - rhs.x; let y = self.y - rhs.y; Point { x, y } } } fn main() { let p = Point { x: 3, y: 6 }; println!("{}", p); assert_eq!(p.to_string(), String::from("3, 6")); assert_eq!(p + p, Point { x: 6, y: 12 }) }

type は型に別名を与えるという役割を持ってます。型に名前をつけると、コメント以上に可読性が上がります。

オリジナルな型のように見えます。 構造体、enum の仲間みたいな。見えるだけでなく、可視性もそんな感じになったはず。

/// 戻り値は、kg単位で返却されます

fn latest_weight(id: usize) -> i32;

/// 戻り値は、cm単位で返却されます

fn latest_length(id: usize) -> i32;type Kg = i32;

type Cm = i32;

fn latest_weight(id: usize) -> Kg;

fn latest_length(id: usize) -> Cm;もう一つは、トレイト定義の自由度を高める使い方があります。

Add、Subなどの計算系トレイトの戻り値は、Output(出力)の方を自由に調整できます。

impl<T> Sub for Point<T>

where

T: Sub<Output = T> + Copy,

{

type Output = Point<T>;

}型 T 自体にも、T を Output とする Sub トレイトを実装している必要があり、

自身もPoint<T>を Output とする Sub トレイトを実装しています。

note

ついでに、Clone, Copy, PartialEq を実装しております

- Clone

構造体の複製を行う clone メソッドを追加する - Copy

デフォルトが move なのを、clone に置き換える

Copy まで実装しておくと楽です。

参照ではない時の値が move から copy に変わるため、所有権が奪われる心配が減ります。

一方で、インスタンスが増えてメモリを圧迫する、同じインスタンスだと思ったら別物だったなんてトラブルもつきます。

数値i32などでは、Copy が実装されています。

- PartialEq

値の比較ができるようになる。

参照で計算できるように工夫する

計算する度にコピーよりか、参照の方がいいと思った。でも中身で結局コピーしちゃうんだよね。

use std::{ fmt::{self}, ops::{Add, Sub}, }; #[derive(Debug, PartialEq, Clone)] struct Point<T> { x: T, y: T, } impl<T> fmt::Display for Point<T> where T: fmt::Display, { fn fmt(&self, f: &mut fmt::Formatter<'_>) -> fmt::Result { write!(f, "{}, {}", self.x, self.y) } } impl<T> Add for &Point<T> where T: Add<Output = T> + Clone, { type Output = Point<T>; fn add(self, rhs: Self) -> Self::Output { let x = self.x.clone() + rhs.x.clone(); let y = self.y.clone() + rhs.y.clone(); Point { x, y } } } impl<T> Sub for &Point<T> where T: Sub<Output = T> + Clone, { type Output = Point<T>; fn sub(self, rhs: Self) -> Self::Output { let x = self.x.clone() - rhs.x.clone(); let y = self.y.clone() - rhs.y.clone(); Point { x, y } } } fn main() { let p = Point { x: 3, y: 6 }; println!("{}", p); assert_eq!(p.to_string(), String::from("3, 6")); assert_eq!(&p + &p, Point { x: 6, y: 12 }) }

Copy の方が楽ですね。

変換に対応させる

タプルから変換できると楽そうですよね。

use std::{ fmt::{self}, ops::{Add, Sub}, }; #[derive(Debug, PartialEq, Clone, Copy)] struct Point<T> { x: T, y: T, } impl<T> fmt::Display for Point<T> where T: fmt::Display, { fn fmt(&self, f: &mut fmt::Formatter<'_>) -> fmt::Result { write!(f, "{}, {}", self.x, self.y) } } impl<T> Add for Point<T> where T: Add<Output = T>, { type Output = Point<T>; fn add(self, rhs: Self) -> Self::Output { let x = self.x + rhs.x; let y = self.y + rhs.y; Point { x, y } } } impl<T> Sub for Point<T> where T: Sub<Output = T>, { type Output = Point<T>; fn sub(self, rhs: Self) -> Self::Output { let x = self.x - rhs.x; let y = self.y - rhs.y; Point { x, y } } } impl<T> From<(T, T)> for Point<T> { fn from(value: (T, T)) -> Self { Point { x: value.0, y: value.1, } } } impl<T> From<Point<T>> for (T, T) { fn from(value: Point<T>) -> Self { (value.x, value.y) } } fn main() { let x: (i32, i32) = (2, 3); let x: Point<i32> = Point::from(x); let (x, y): (i32, i32) = x.into(); }

Fromトレイトを実装すると、変換が可能になります。 今回はタプルから Point へ、Point からタプルへ変換できるようにしました。

main 関数では、相互変換を実装しています。

2 行目は From の使い方です。 from はいわゆる静的メソッドであり、new メソッドのように新たなインスタンスを作ることを目的としています。

つまり、変換先のインスタンスは別物です。 そりゃそう。

一方で、3 行目は into メソッドによってタプルに変換されています。インスタンスについているメソッドですね。

From トレイトを実装すると、自動的に実装されます。

note

Into は From の逆だと聞いて、相互変換と考えてしまった時期がありました。

実際には、静的メソッドかただのメソットか、その差です。

相互変換に対応させるために、お互いに From トレイトを適用しています。

これによって相互変換ができるようになるのです。

into 使う時は、型注釈が必要です。

まとめ

オリ曲の存在を証明するには、私の頭を解剖するしかない。

クレート紹介 part1

書くネタないわけでは)ないです。

本日の一言

これはやばい。 浄化されて消えかける。

anyhow

エラー処理がぐーんと楽になるやつです。 標準で Error トレイトが存在するのは知ってましたが、使わざる得なくなりました。

anyhow::Result

anyhow::Result を使えば、他のことを考えないで済むようになりました。

anyhow::anyhow

anyhow マクロです。

extern crate anyhow; use anyhow::{anyhow, Result}; fn main() -> Result<()> { let reason = "エラープログラムだから"; Err(anyhow!("原因は{}", reason)) }

Error トレイトを実装したオブジェクトを文字列から簡単に作れます。

format も使えるので、{:?}でオブジェクトの中身を表示させられたりすることもできます。

anyhow::bail ensure

extern crate anyhow; extern crate rand; use anyhow::{Result, bail}; fn main() -> Result<()> { if rand::random() { bail!("random error"); } Ok(()) }

anyhow!に加え、return Err()まで実装してくれるマクロです。

extern crate anyhow; extern crate rand; use anyhow::{Result, ensure}; fn main() -> Result<()> { ensure!(rand::random::<bool>(), "random error"); Ok(()) }

assert!と同じような効果を持ってます。

使い方

strum

enum を使いやすくしてくれます。

enum との変換が楽になる

#[derive(Debug, Clone, PartialEq, Eq, strum_macros::Display, strum::EnumString)]

pub enum Version {

#[strum(serialize = "HTTP/1.0")]

Http10,

#[strum(serialize = "HTTP/1.1")]

Http11,

#[strum(serialize = "HTTP/2.0")]

Http20,

#[strum(serialize = "HTTP/3.0")]

Http30,

}EnumStringはFromStrトレイトを実装してくれます。

おかげで、

Version::from_str("HTTP/1.0");と、文字列から enum オブジェクトを生成できる他

Displayによって、トレイトのディスプレイを自動で実装できます。

上記のように、オブジェクトを持つというより、バージョンや定数を管理する時に楽になります。

使い方

構文解析 part1

公開日:2025/08/28

構文解析について、お話しします。

ひとくちメモ

彩澄姉妹が最近好きでして。

初めて声を聞いたのは、ほんの偶然というか。ボイロ劇場みてたらナレーターとして使われてた。

りりねぇが少なめですまねぇ。決してアレではない

参照(ポインタ)

C を学ぶ時、ポインタを知ります。 ポインタってどこで使うんだとなるわけです。

rust にもポインタが存在しますが、近い存在として参照があります。

tip

一方 C にも参照は存在する

じゃあ実際参照とポインタって何が違うんだよ

って話になるよね。

独自研究マシマシで回答を作成してみると

rust ではポインタの登場頻度は低い方だと思います。 参照は所有権的問題をクリアするためにある、そういった物です。

一方ポインタはあくまでアドレスのみの管理です。型も大雑把にしか管理しません。 rust では unsafe となります。

C のポインタ、参照も似てる。 ポインタはキャストすれば int を char として扱うなんて容易いし。

compiler explorerで見てみる

compiler explorerはコンパイラーが出力するアセンブリを表示する web サイトです。便利。

int main() {

int x = 3;

int& y = x;

int z = x;

return 0;

}

main:

push rbp

mov rbp, rsp

mov dword ptr [rbp - 4], 0

mov dword ptr [rbp - 8], 3

lea rax, [rbp - 8]

mov qword ptr [rbp - 16], rax

mov eax, dword ptr [rbp - 8]

mov dword ptr [rbp - 20], eax

xor eax, eax

pop rbp

ret

block-beta

columns 1

A ["先頭"]

B ["rbp-8: x"]

C ["rbp-16: y"]

D ["rbp-20: z"]

スタックを雑にまとめるとこうなりますね。

rbp という先頭アドレスから、いくら離れているかを載せています。

なお、アドレスはバイトごとに管理されるため、rbp-1 は、rbp から 8bit 離れているということになります。

一方で、mov は move という意味です。

mov dword ptr [rbp - 8], 3

なんてrbp - 8に 3 という値を代入(移してる)しているという意味なので、簡単です。

lea はアドレスを取り出すという物です。 64bit コンピューターなので、アドレス長は 64bit

その位置はちょうど参照yになってるところです。 y は x のアドレスを持っています。

int main() {

int x = 3;

int *xp = &x;

}

ポインタで書き直しました。

main:

push rbp

mov rbp, rsp

mov dword ptr [rbp - 4], 3

lea rax, [rbp - 4]

mov qword ptr [rbp - 16], rax

xor eax, eax

pop rbp

ret

やってることはほとんど同じですね。

rust では安全な参照が、c ではポインタがよく使われています。

参照が安全なのは前述の通り、rust ではアドレス以上に所有権などの考慮もしながら扱う物だからです。多分。

アセンブリからしたら型もくそもないけれど、コンパイラの時点で変数が用途通り使われているのを確認できているので問題ないのです。

指定した容器に情報を詰め込んで

今マイバック持参とかあるじゃないですか。あとマイカゴ。

マイカゴって、スーパーのレジ店員に渡すとそのまま品物を中に詰めてくれるので、こちらとしてそのまま車に詰め込んで、持ち帰って終わるだけなので楽なんですよね。

#[derive(Debug)] struct Goods<'str> { _name: &'str str } fn registrar<'str>(mut unpurchased: Vec<Goods<'str>>, mybag: &mut [Option<Goods<'str>>]) -> (usize, Vec<Goods<'str>>) { let mut counter = 0; for i in mybag.iter_mut() { if i.is_none() { *i = unpurchased.pop(); counter += 1; } } (counter, unpurchased) } fn main() { let unpurchased_list = vec![Goods{_name: "pan"}, Goods{_name: "kome"}, Goods{_name: "tofu"}]; let mut my_bag: [Option<Goods>; 2] = [None, None]; let (size, pra_bag) = registrar(unpurchased_list, &mut my_bag); println!("レジ袋: {:?}", pra_bag); println!("マイバッグに入れられた品物: {:?}", my_bag); println!("マイバッグに入れられた品物の数: {}", size); }

というのを想像して書いてみたらこういうプログラムができました。

Cloneを実装してないので商品(Goods)は move のみできます。現実の商品コピーできないからね。

レジ(registrar)にはカゴ(unpurchased_list)とマイバッグ(my_bag)を渡します。

なお、マイバックは一時的に貸しているものであり、帰ってきます。 参照渡しとはそういうことです。

会計が済めば、入り切らなかった商品がレジ袋(pra_bag)に詰められて帰ってきます。

丁寧な店員なので、マイバッグに入った品物の数も答えてくれました。

「あんちゃんが渡してくれた袋に二品つっこめたで」

ポインタのほんの一つの使い方はこんな感じです。

rust では一時的に貸すという表現ができますねぇ。

そのまま渡して返して貰えばいいのでは?

レジ袋って無駄だと騒がれてるじゃん?

C 言語の関数の戻り値ってアドレスが異なるのです。

正しくは、関数の結果を変数にコピーするという動作を行ったはずです。

rust ではあんまり関係ないですが。少なからず戻り値での受け渡しは無駄が生じる可能性があるということです。

また、現実の my_bag 同様、変数の再利用ができます。

変数って作るときにコストが生じます。 特に Box で作るとなると、ヒープ確保にコストがかかります。

java なら GC があるので、GC が回収するオブジェクトが無駄に増えることになります。

変数って単純なようで奥深いです。 rust ではトレイトがあります。

トレイトオブジェクトでリストを管理すれば、変数の扱いを自分なりにカスタマイズできるようになるのです。

とにかく、自分が用意したものを相手に使ってもらいたい時に、ポインタは有用だということなのです。

note

rust では参照です。

関数をやり取りする時

関数を変数として扱うことがあります。

fn func() {}

fn main() {

let f = func;

}rust においてこの構文は、f は関数の参照を持っているという扱いになります。

計算に使用される数値、文字を表現するために使われる文字列。これらは値として管理することができます。

一方で、関数は値というより、式の一つと考えられます。 式が値になるというこんがらがるような状況になります。

しかし関数値というのは存在しません。関数を 「指し示す」 参照が存在するだけです。 参照は「値」です。

関数をさす参照という値を使うことで、引数を通じて他の関数に関数を渡すことができます。

tip

C では関数ポインタが使われます

コールバック関数

それこそがコールバック関数です。

mod my_crate { use std::time::Duration; use std::thread::sleep; pub fn callback(func: impl FnOnce(&str)) { sleep(Duration::from_secs(2)); func("callback"); } } fn func(i: &str) { println!("hello world {}", i); } fn main() { let f = func; my_crate::callback(f); }

my_crate::callbackは、my_crate というクレート(つまりライブラリ)のcallbackという関数のことです。

コードをあえて隠してますが、表示すればモジュールが見えるはずです。

callback という関数は、2 秒待機した後にユーザーが指定した関数を呼び出します。

呼び出される関数はユーザーが自由に設計できます。(ただし引数と戻り値は一致しなければならない)

コールバック関数の出番

- 〇〇した後に呼び出す(処理順序)

主に非同期処理で見られます。 非同期でなくても、マルチスレッドで可能。

処理が終えた時にユーザーの関数を実行するという動作をします。 - 関数の自由度を高めるため

引数、戻り値だけを指定し、ユーザーに処理を考えて欲しいことがあります。 あとで出てきます。

note

イベント駆動する javascript では、イベントとして関数を登録し、ファイルが読み込み終わった時などにイベント発火として関数が呼び出されます。

関数を作る関数

ややこしい概念です。

fn func_builder(msg: &str) -> impl Fn(&str) { let msg = msg.to_string(); move |user| println!("dear {}\n{}", user, msg) } fn main() { let f = func_builder("hello! have a nice day!"); f("nikki"); }

|| {}はクロージャです。 他言語ではアロー関数、ラムダ関数とか呼ばれたりします。

特徴として、値のように関数の中で関数が定義できます。

Fnトレイトは、関数トレイトです。 関数型として変数を管理することができます。

戻り値を関数型にするために使ってます。 先ほどは引数にも使ってました。

コンビネーター

callback 関数は他に、関数を加工する時、関数を組み合わせる時に便利に使われます。

fn can_i_help_you() { println!("いらっしゃいませこんにちは"); } fn booko0f(func: impl Fn()) { for _ in 0..3 { func(); } } fn main() { booko0f(can_i_help_you); }

関数を組み合わせて機能を強くする例です。ブック ⚪︎ フか。

パーサー

こういうやつです。

fn digit_parser(i: &str) -> (&str, Option<i32>) { let n = i.find(|c: char| !c.is_ascii_digit()).unwrap_or(0); if let Ok(res) = i[0..n].parse::<i32>() { (&i[n..], Some(res)) } else { (&i, None) } } fn main() { let x = "123hello"; let (x, y) = digit_parser(x); println!("{:?}, {:?}", x, y); }

文字列から数値だけ抽出します。 その後、数値と文字列を分割して出力します。

rust ではシャドーイングする設計にすると綺麗です。

パーサーコンビネーター

fn digit_parser(i: &str) -> (&str, Option<i32>) { let n = i.find(|c: char| !c.is_ascii_digit()).unwrap_or(0); if let Ok(res) = i[0..n].parse::<i32>() { (&i[n..], Some(res)) } else { (&i, None) } } fn looparser<P, T>(parser: P) -> impl Fn(&str) -> (&str, Option<(&str, T)>) where P: Fn(&str) -> (&str, Option<T>) { move |i| { for n in 0..i.len() { let (i2, res) = parser(&i[n..]); if let Some(res) = res { return (i2, Some((&i[..n], res))) } } (i, None) } } fn main() { let x = "hello123world"; let (x, y) = looparser(digit_parser)(x); println!("{:?}, {:?}", x, y); }

コードが急にカオスになりました。

looparser

名付け適当 digit_parser は「数文字が先頭から続く範囲で数値を取り出します。」

つまり、途中の数値は取り出されません。

fn digit_parser(i: &str) -> (&str, Option<i32>) { let n = i.find(|c: char| !c.is_ascii_digit()).unwrap_or(0); if let Ok(res) = i[0..n].parse::<i32>() { (&i[n..], Some(res)) } else { (&i, None) } } fn main() { let x = "hello123"; let (x, y) = digit_parser(x); println!("{:?}, {:?}", x, y); }

数値が後ろになるだけでパースできなくなりました。 looparser では、パーサーが成功するまで文字列の先頭をずらしながら試行錯誤するという物です。

よって、"hello123world"では、6 文字目から digit_parser が成功し、数値に変換して返すということができるようになりましたとさ。

パーサーという関数を受け入れる関数

looparser では、関数をあたかもParser というオブジェクトのように扱っています。

こういった時にも関数ポインタは必要になるのですね。

コード解説

fn digit_parser(i: &str) -> (&str, Option<i32>) {

let n = i.find(|c: char| !c.is_ascii_digit()).unwrap_or(0);

if let Ok(res) = i[0..n].parse::<i32>() {

(&i[n..], Some(res))

} else {

(&i, None)

}

}i は文字列。 str.find()は、引数にコールバック関数を入れます。

ここでもコールバック関数がっ...

コールバック関数の引数は char にしておきます。 そうすることで、find メソッドがコールバック関数に先頭から文字を一文字づつ入れて、試してくれます。

コールバック関数の戻り値は bool です。 true を返すと、成功(=条件に合う文字)と判定されます。

つまり、find メソッドは先頭から一文字ずつ試していき、条件に会う文字を見つけたらその文字があるインデックスを返すというメソッドになります。

戻り値

戻り値は(&str, Option)という形をとってます。

let base = "123hello";

let (base, res1) = parser1(base);

let (base, res2) = if res1.is_none() {

parser2(base)

} else {

(base, None)

}まぁこんな感じの書き方ができるよねってことで。

クロージャのキャプチャ

fn looparser<P, T>(parser: P) -> impl Fn(&str) -> (&str, Option<(&str, T)>)

where P: Fn(&str) -> (&str, Option<T>)

{

move |i| {

for n in 0..i.len() {

let (i2, res) = parser(&i[n..]);

if let Some(res) = res {

return (i2, Some((&i[..n], res)))

}

}

(i, None)

}

}moveというのは所有権関係の物です。

looparser のスコープにはparserというこれまた関数オブジェクトが存在します。

このparserの所有権を、クロージャに移動することを認める一言になってます。

クロージャ内部では、キャプチャした parser オブジェクトがそのまま使えます。 つまり、looparser でうけっとったコールバック関数を、クロージャ内部で使うことができるということになります。

looparser は戻り値で関数ポインタを渡してきますが、そのクロージャでも looparser が受け取ったコールバック関数が引き続き利用可能です。

note

impl について、これをつけておくとプログラムサイズを犠牲に、どんなものにも対応できるように関数が作られます。

どういうことかって、トレイトは本来、実体しないものです。 サイズがわかりません。

おそらくトレイトが実装されている元のオブジェクトをたどって、どんなオブジェクトも受け入れられるように関数を作る、そういうことだと勝手に理解してます。

なお、引数で impl を使うときはジェネリクスと where で一度定義する必要があります。

今回のまとめ

ポインタからコールバック関数、そしてパーサーコンビネーターまでとりあえず纏めてみました。

本題まで行けてないのが悲しい。

本日の二言

本日が終わるまであと 4 時間です。 急いで書きました。

え?何してたって? 単純に記事のボリュームがデカすぎるという問題もあるのですが、MyParserProject どうしようかなって考えてました。

実はそれをいじってて急遽書いた記事でもあります。

...それだけじゃないだろって?

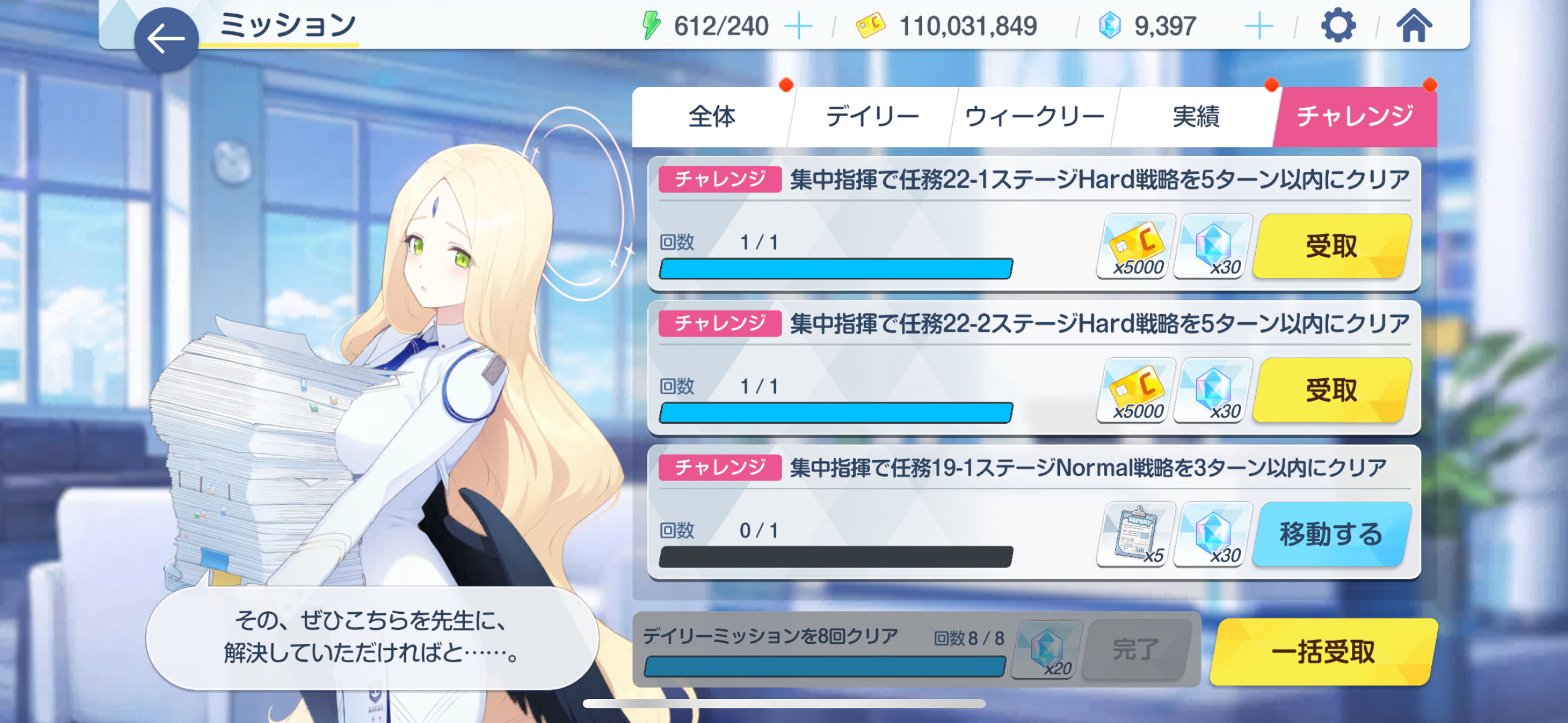

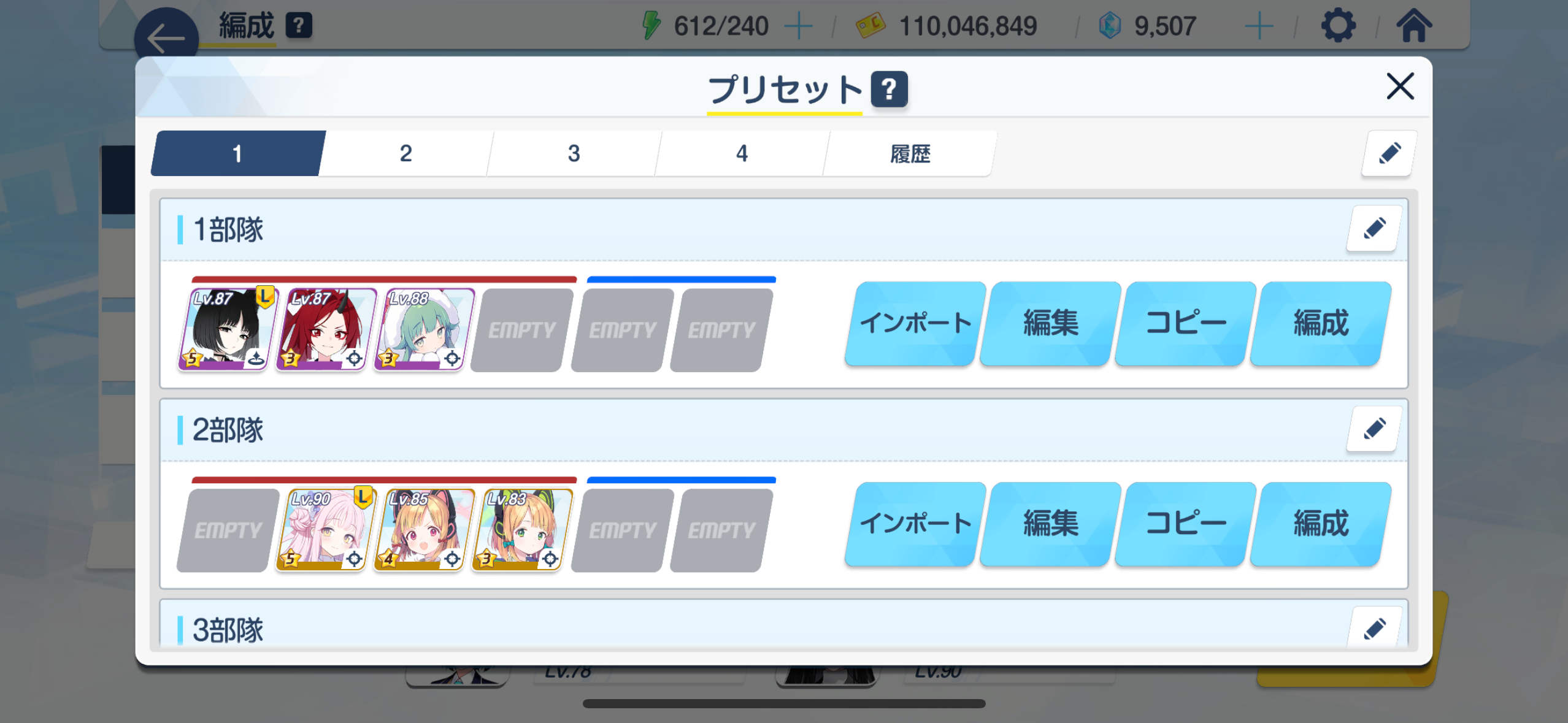

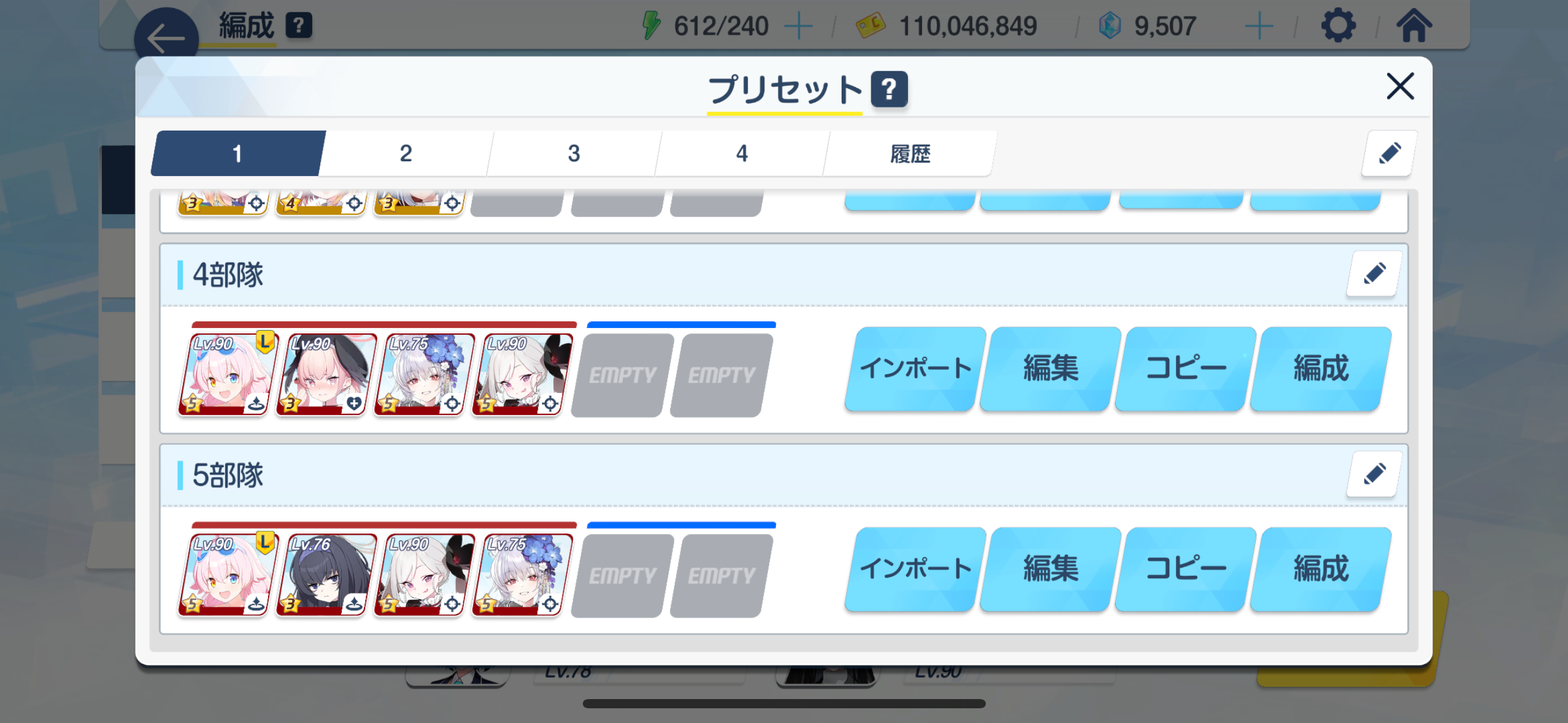

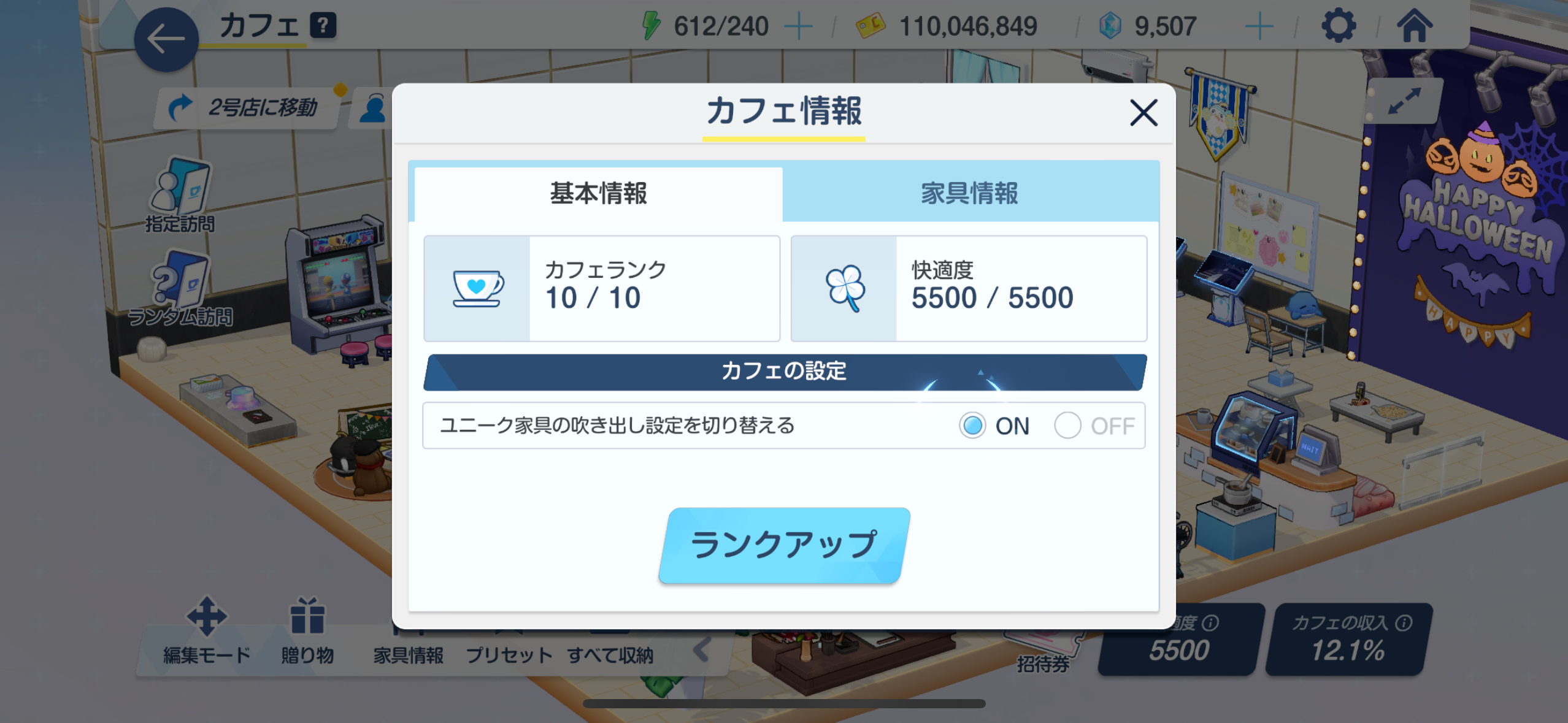

あのですね。 ブルアカってゲームあるじゃないですか。

最近ワイルドハント芸術学院という学院が追加(※)されまして、そこに所属する二人が予想以上に可愛くてね。

note

いろんな記事曰くワイルドハント芸術学院自体はリリース初期から存在するそうです。

所属するキャラがプレイアブルキャラクターとして追加されたのは正真正銘今回が初です。

魔女っ子よくね? やっぱいいよな。白尾エリめっちゃいいよな?

いや、ワイルドハント芸術学院、能力的には他のキャラで代用できるし、そもそも進化用のノートが独自の枠だから集めるのめんどいし

ぶっちゃけ微妙だよな... 引こうかな...

でもチケット 2 枚残ってるんだよね

...

結果

2敗

🟦🟨🟦🟦🟦

🟦🟦🟦🟦🟦

🟦🟨🟦🟦🟦

🟦🟦🟦🟨🟦

構文解析 part2

今回は一瞬で終了します。 ひとくちメモレベル

本日の一言

ペロロジラのおかげで、自分が持つキャラの中でも神秘キャラが一番弱いことに気づきました。

思えば振動キャラが少ないと思ってたので、そればかり強化してたし、神秘キャラとをほぼ同一視してたのでこうなることは仕方なかったと思います。

現時点では、取り急ぎワカモと臨戦ホシノを強化することにしました。 アビドスのノートほぼ残ってない...

びびりっか

パーサークレートについて

rust には nom というパーサークレートが存在する。

chumsky というパーサークレートも存在する。

使い分け、わからん。

When to use this instead of nom? (chumsky の issue より)曰く、

(要約)

nom はバイナリ向け。 chumsky は文字列向け。

とのこと。

あと、Logos というクレートも存在し、これはLexerと呼ばれるもの。

Understanding the Differences – Lexer vs. Parser Explained

どれも文字列やバイナリ列などのコードを解釈し、オブジェクトやトークンに直すもの、そう理解してる。

Logos を使ってみる

use logos::Logos;

#[derive(Logos, Debug, PartialEq)]

#[logos(skip r"[ \t\n\f]+")] // Ignore this regex pattern between tokens

enum Token {

// Tokens can be literal strings, of any length.

#[token("+")]

Add,

#[regex("[0-9]")]

Number,

}

fn main() {

let mut lex = Token::lexer("1 + 1");

assert_eq!(lex.next(), Some(Ok(Token::Number)));

assert_eq!(lex.next(), Some(Ok(Token::Add)));

assert_eq!(lex.next(), Some(Ok(Token::Number)));

}こんな感じで、大雑把にそれが何なのかを表してくれる。 文字列で出力するようにすれば

fn main() {

let mut lex = Token::lexer("1 + 1");

println!("{:?}, {:?}", lex.next().unwrap(), lex.span());

println!("{:?}, {:?}", lex.next().unwrap(), lex.span());

println!("{:?}, {:?}", lex.next().unwrap(), lex.span());

}Ok(Number), 0..1

Ok(Add), 2..3

Ok(Number), 4..5

example の json を動かしてみる

コードはこれ git clone で持ってきた方が楽。

cargo run --example json -- <filename>.json

で動かせる。

{

"name": "yjsnpi",

"age": 24

}

Object(

{

"\"name\"": String(

"\"yjsnpi\"",

),

"\"age\"": Number(

24.0,

),

},

)

感想(2025/08/29 時点)

ほぼ私が想像するパーサー?

言語はもちろん、json みたいな独自のデータ記述言語を扱う時には Logos を使った方が手っ取り早いかもしれない。

chumsky を使ってみる

use chumsky::{

Parser,

error::Simple,

extra,

prelude::{any, end, just},

};

fn main() {

let base = ":helloworld";

let parser = just::<_, _, extra::Err<Simple<char>>>(':')

.then(any().repeated())

.then(end());

let x = parser.parse(base);

println!("{:?}", x);

}parse というメソッドを使うことでパースされます。

them メソッドでパーサーを連結させることができます。

ドキュメント

ガイド をベースに軽く触れてみました。

repeated について

repeated メソッドを使うことによって、パーサーを繰り返し実行することができるようです。any パーサーは終端文字以外の全てにマッチするようなので、マッチする間は繰り返されます。

ところでこれ、イテレーターに近い動作をします。

IterParser

IterParser repeated メソッドをつけると、実装されたパーサーになります。

と言いつつ、使えるのは fold および collect のようです。 map や filter はrepeated の手前で行うらしい。

感想(2025/08/29 時点)

まだ正気よくわかってない。

nom

だいぶ前から使ってきた。

stream vs complete

最初のページに書かれている通り、一部のパーサーで動作が変わってくる。

alpha0 は 0 以上のアルファベットキャラクターをパースする。正規表現で言う[a-zA-Z]*である。

"abcd"のように仮に全てパースに成功する場合でも、stream は続きがあると想定され、パースが失敗するまで(;などの文字にぶち当たるまで)はエラーを出力する。

コード例

use chumsky::{

IterParser, Parser,

error::Simple,

extra,

prelude::{any, end, just},

};

mod nom_parser {

use nom::{

IResult, Parser,

character::complete::{alpha0, char},

sequence::pair,

};

pub fn parser(i: &str) -> IResult<&str, (char, &str)> {

pair(char(':'), alpha0).parse(i)

}

}

fn main() {

let base = ":helloworld";

let parser = just::<_, _, extra::Err<Simple<char>>>(':')

.then(any().repeated().collect::<String>())

.then(end());

let x = parser.parse(base);

let y = nom_parser::parser(base);

println!("{:?}", x);

println!("{:?}", y);

}ParseResult { output: Some(((':', "helloworld"), ())), errs: [] }

Ok(("", (':', "helloworld")))

下が nom によるパース結果です。 Result は nom の方がシンプルにできてるように見えます。

char はそのままだと型予測ができないので、何かしらの方法で型注釈をしないと使えなかったです。

pair でまとめましたが、この場合はこう書いた方が自然らしい。

let (i, r1) = char(':')(i)?;

let (i, r2) = alpha0(i)?;

Ok(i, (r1, r2))参考サイト

Rust: nom によるパーサー実装が相当丁寧にまとまっていてわかりやすいです。

nom はバイナリ向きか

byte モジュールにバイトデータを扱うための関数があります。

nom は多種多様な用途で使用可能な構造に見えました。

しかし、文字列系の関数については chumsky の方が簡単に使える気がします。

まとめ

chumsky についてもっと深めたい。

nom は多機能なのと、バイナリに向いている気がします。

ところでバイナリ解析とは

バイナリも文字列同様、二進数列です。

文字解析の場合は記号や文字の並び順で解析し、それに従ってオブジェクトを作ります。

バイナリの場合はプロトコルや規格でどこに何があるか、1bit 単位で位置が決まってることがほとんどなので、

それに従って使いやすいオブジェクトに変換していきます。

本日の二言

いやぁまじで草可愛い。

ちっちゃな私聞いてて思わずタグ検索「はじめてのチュウ 重音テト」してしまった。

MIMI さんの PV 好きすぎて。

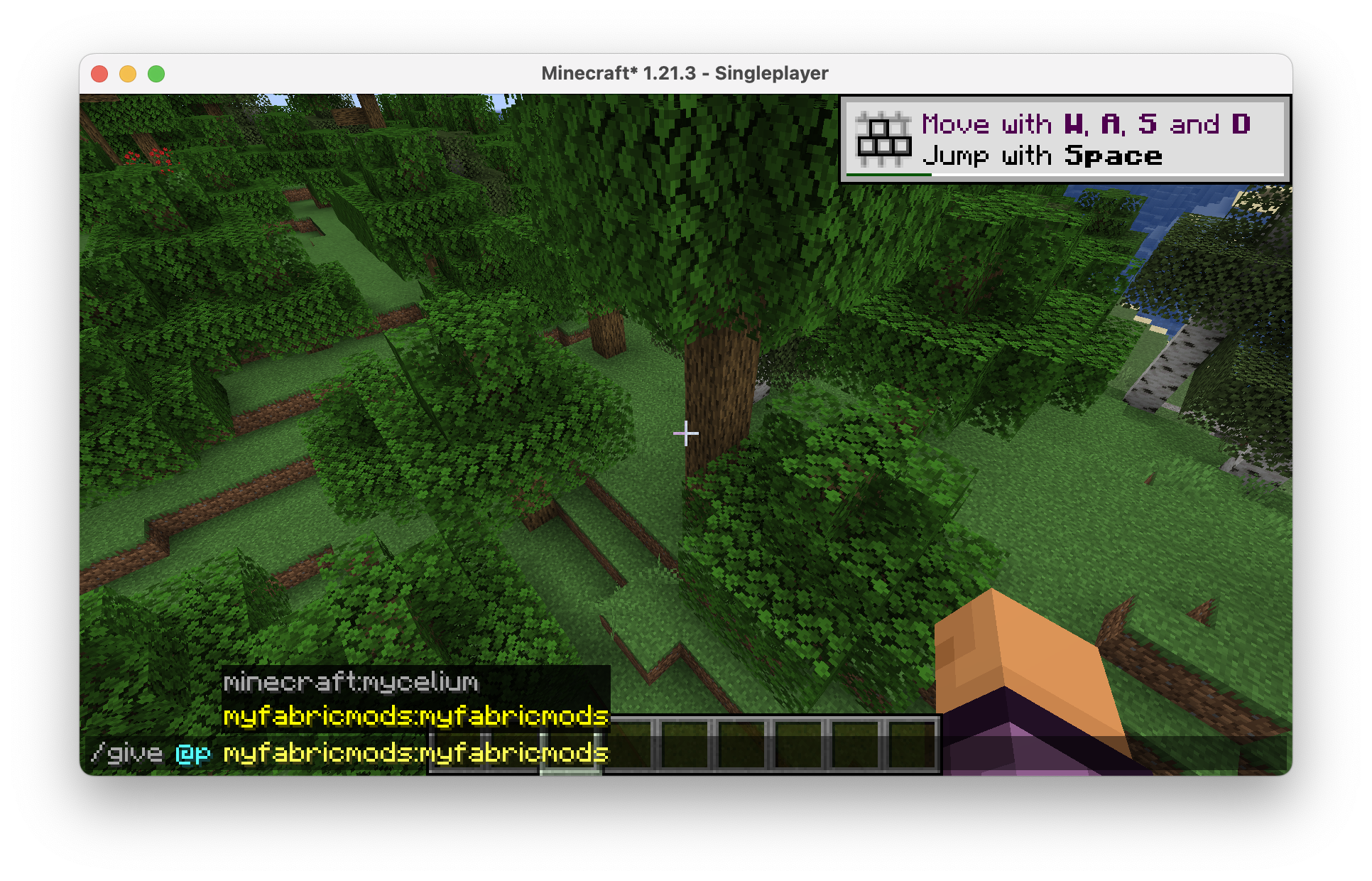

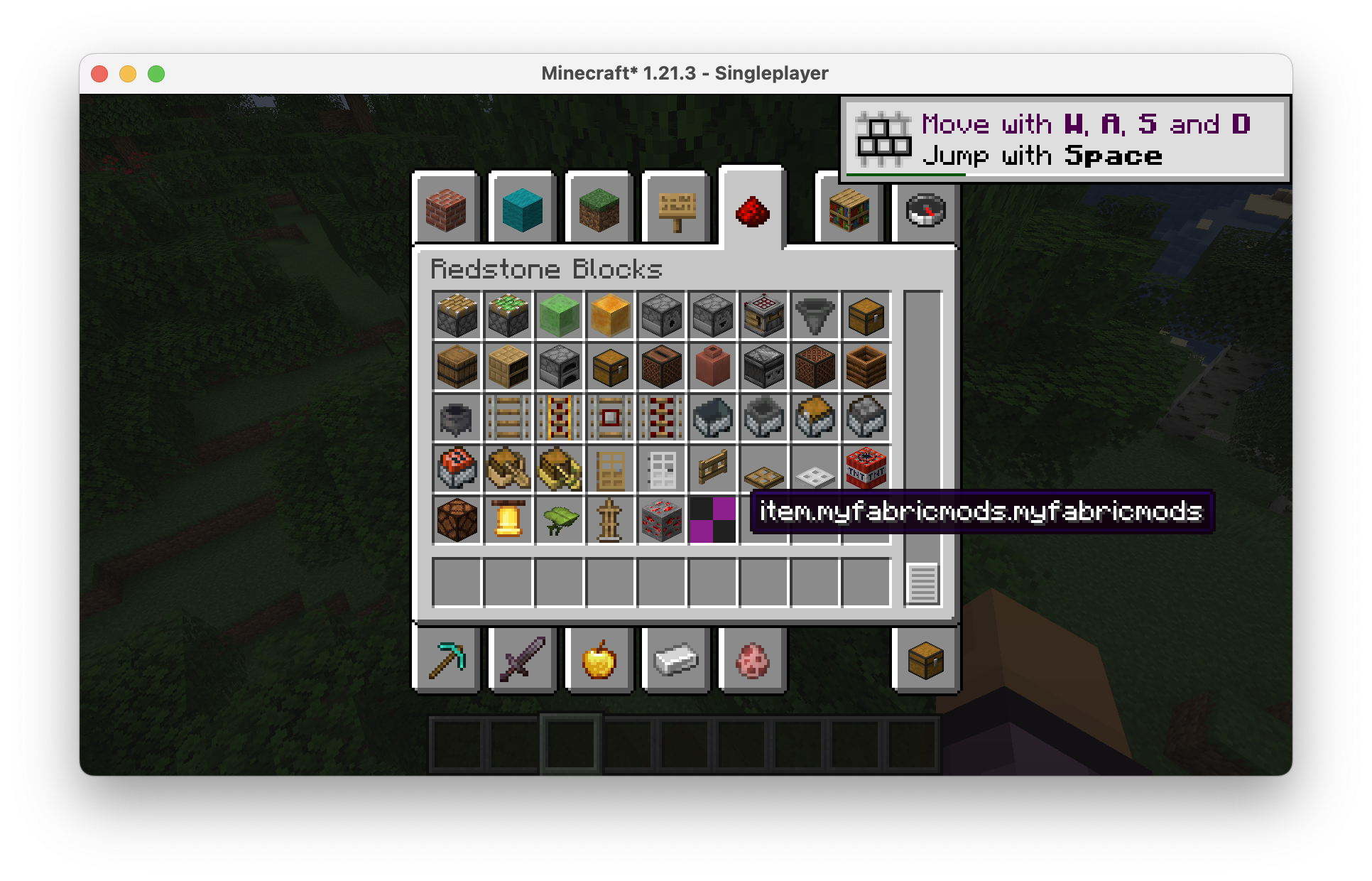

Minecraft 系

Minecraft の mod や plugin、コマンドなどを扱う時の備忘録を集めてます。

なお、個別プラグインの備忘録は個別で書いている場合があります。

- 基礎編

mod にも plugin にも通用しそうなことを書いてます。 - plugin 編 主に bukkit 系 プラグインの話題を書いています。

- mod 編 主に forge、それと fabric 系の話題を書いています。

基礎編 part1

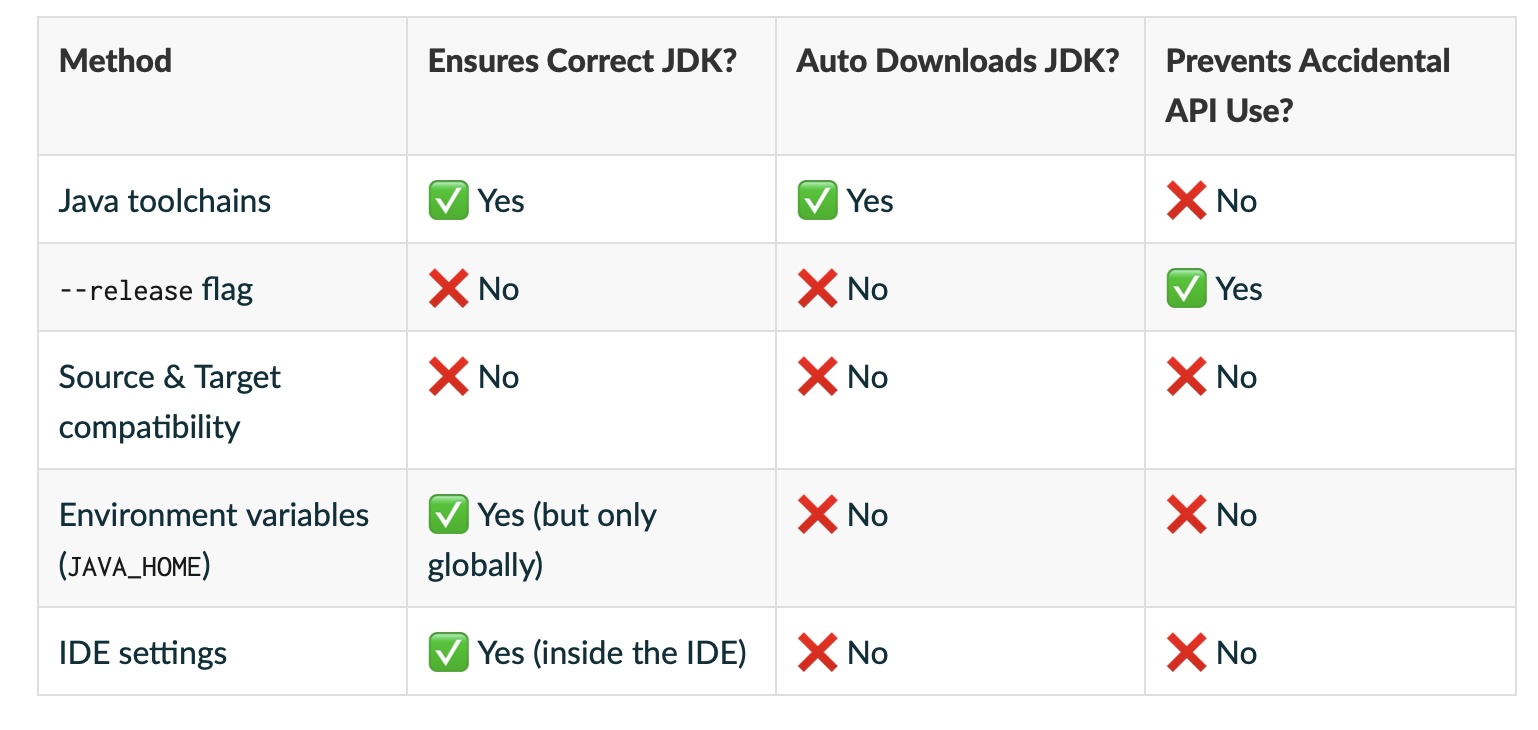

地味に gradle について理解を深める必要があるため、それを先にやってしまいたいと思います。

🎵 本日の一曲

夏ですね。 暑い、暑い、暑すぎる。

ところで爽快感のある曲はいいですね。 木陰に隠れる琴葉姉妹を見て、そういえば木陰は本当に涼しいことを思い出しました

湿度などによりますが、木陰は嫌な暑さだとは思わないんすよね。 ただ、近くを車が通っていたり、室外機があったりすれば別ですが。

...山しかなくね?そんなとこ。 山は割と涼しい。 つまり木陰が涼しいというより山が涼しい。 qed 署名終了。(強引)

前提について

筆者は mac 環境および linux 環境で作業してます。 最近 windows と縁がないもので...

java について、openjdk がおすすめです。 といってもたくさんありますので、おすすめ書いときます

note

ここでインストールしておく必要はありません。 sdkman でまとめて導入可能です。

sdkman を入れてみる

sdkman

最近人気な、シェルスクリプトを用いて全自動で入れてくれるやつでインストールできるのかぁ。

apt install -y unzip # 必要とのこと

curl -s "https://get.sdkman.io" | bash

sdk install gradle # graldeを入れる

> gradle -v

Welcome to Gradle 8.14.2!

Here are the highlights of this release:

- Java 24 support

- GraalVM Native Image toolchain selection

- Enhancements to test reporting

- Build Authoring improvements

For more details see https://docs.gradle.org/8.14.2/release-notes.html

------------------------------------------------------------

Gradle 8.14.2

------------------------------------------------------------

Build time: 2025-06-05 13:32:01 UTC

Revision: 30db2a3bdfffa9f8b40e798095675f9dab990a9a

Kotlin: 2.0.21

Groovy: 3.0.24

Ant: Apache Ant(TM) version 1.10.15 compiled on August 25 2024

Launcher JVM: 21.0.8 (Ubuntu 21.0.8+9-Ubuntu-0ubuntu124.04.1)

Daemon JVM: /usr/lib/jvm/java-21-openjdk-arm64 (no JDK specified, using current Java home)

OS: Linux 6.10.14-linuxkit aarch64

> which gradle

/root/.sdkman/candidates/gradle/current/bin/gradle

> echo $PATH

/root/.sdkman/candidates/gradle/current/bin:/usr/local/sbin:/usr/local/bin:/usr/sbin:/usr/bin:/sbin:/bin

イイネ 👍

note

which sdkを試したがなぜだかコマンドが出なかった。 set など調べると、シェルスクリプトの関数として動いているようだ。

なんと java も入る。

sdk install java 21.0.8-zulu

色々触れてみる

gradle initでプロジェクトを生成できる。

WORKDIR=$(mktemp -d);

cd $WORKDIR;

# gradleプロジェクトを初期化する

gradle init

とりあえず環境構築まで

sdkman は革命だね。 次回以降は割と簡単に進むと思います。

以下過去の話

java の入れ方

JAVA_HOME の設定などをお勧めされているのや、PATH を設定しているのをよく見ますが、あれ意味を理解していれば効率よく運用できるはずです。

PATH とは(AI による説明)

- PATH は環境変数のひとつで、OS に「どこにコマンドを探しに行くか」を教える役割を担っています。

- コマンド実行時、PATH に登録されたディレクトリの順序に従って、最初に見つかった同名ファイル・コマンドが使われます。

- PATH が空だと OS は「どこを探せばよいかわからない」ので、どんなコマンドもフルパス指定が必要になります。

例:/bin/ls のように絶対パスで書けば実行可能

でも、単に ls とだけ入力しても "command not found" になります export PATH="$PATH:/your/custom/path"で PATH に使うディレクトリを追加可能。

PATH=$PATHがないと、既存の PATH が消えるので注意

# 個人用実行ファイルを作ってみた

WORKDIR=$(mktemp -d)

cd $WORKDIR

# 実行ファイル作成

cat << EOF > run.sh

#!/bin/sh

echo "hello world"

EOF

chmod +x run.sh # 実行権限設定

./run.sh # 実行可能

export PATH="$PATH:$WORKDIR" # パスに追加してみる

run.sh # 実行可能

echo $PATH # PATHの内容もこれで確認可能

なーるほど。 そうやって使うのね。 完全に理解した。

てか、シェルの変数と環境変数、ごっちゃになりそうだな。なんで export って名前なんだろう。

しかもシェルはアクセス方法が変数、環境変数ともに差がないんだよなぁ。

JAVA_HOME について

最近使ってないからわからなくなった。 考えるのをやめた。思考停止。

つまり不要ってことだ。

direnv を使おう

- direnv

ディレクトリごとに環境変数を変えられるのが特徴。 マインクラフトは java1.12 以降 jre/jdk8 が必要、確か 1.19 以降は jre/jdk17、1.20 以降は jre/jdk21 が必要である。

これは mod 開発時にも影響を及ぼす。 そのときに使えるのが direnv である。

note

ただし、後述する gradle をうまく活用すれば問題ないと思うけれど

Toolchains for JVM projects

...ん?

.......ん????

gradle について

java 版の cargo です。 これを使えば外部コードの連携から、ビルド、テストまで、行ってくれます。 多分優れもの。

tmpにプロジェクトを作ってみましょう。

gradle を導入してみよう。

gradle も バージョン依存激しいです。

とりあえず最新版入れてればなんとかなりますが...

brew install gradle(sdkman を使う場合は sdkman を入れてみるの項目で説明)apt install gradle

この辺のコマンドで入るかと。

caution

流石に適当言ってられないから、docker で無理やりapt install -y gradleしたんだけど、ぼくのしってる挙動とちがうんだけどー!

...

gradle -v

Gradle 4.4.1

古すぎるじゃねぇか!!!

tip

ああ、windows をお使いで?

wslgも参考のこと

これで(Linux 環境が)できた。

基礎編 part2(随時更新予定)

前回 sdkman が使いやすいというお話を致しました。

追記

投稿日とバージョンについて

後述しますが、gradle はバージョンによっての変化が激しいため、先に日程と gradle の最新版の確認をお願いします。

なお、日記さん側でも変化があったら修正するよう心掛けるつもりではありますが、放置する可能性もあるのでよろしくお願いします。

- 投稿日: 2025/07/28

- Gradle の Version:

Gradle 8.14.2

🎵 本日の一曲

PV 可愛すぎる

星界ちゃんとお出かけしたいよね。

gradle で環境構築をしてみる

gradle initを実行すると、最初に

- Application(実行ファイル)

- Library(ライブラリ)

を聞かれる。(あと Basic と Gradle plugin があるがここでは省略) 実際に生成してみて違いを確かめてみた。

アプリケーションの場合

>gradle init

Select type of build to generate:

1: Application

2: Library

3: Gradle plugin

4: Basic (build structure only)

Enter selection (default: Application) [1..4] 1

Select implementation language:

1: Java

2: Kotlin

3: Groovy

4: Scala

5: C++

6: Swift

Enter selection (default: Java) [1..6] 2

Enter target Java version (min: 7, default: 21): 21

Project name (default: tmp.q5kXPDaYCv):

Select application structure:

1: Single application project

2: Application and library project

Enter selection (default: Single application project) [1..2] 1

Select build script DSL:

1: Kotlin

2: Groovy

Enter selection (default: Kotlin) [1..2] 1

Select test framework:

1: kotlin.test

2: JUnit Jupiter

Enter selection (default: kotlin.test) [1..2] 1

Generate build using new APIs and behavior (some features may change in the next minor release)? (default: no) [yes, no]

> Task :init

> Learn more about Gradle by exploring our Samples at https://docs.gradle.org/8.14.2/samples/sample_building_kotlin_applications.html

BUILD SUCCESSFUL in 13s

1 actionable task: 1 executed

>tree

.

├── app

│ ├── build.gradle.kts

│ └── src

│ ├── main

│ │ ├── kotlin

│ │ │ └── org

│ │ │ └── example

│ │ │ └── App.kt

│ │ └── resources

│ └── test

│ ├── kotlin

│ │ └── org

│ │ └── example

│ │ └── AppTest.kt

│ └── resources

├── build

│ └── reports

│ └── configuration-cache

│ ├── 4oniusdp5r7fugbijssf0wr1j

│ │ └── 5q136g6kyf5rmfirte8rxuy4s

│ │ └── configuration-cache-report.html

│ └── ey2md2b405fd5q446rzq48txv

│ └── 74ftzik9peji2a08l95gz9c0j

│ └── configuration-cache-report.html

├── gradle

│ ├── libs.versions.toml

│ └── wrapper

│ ├── gradle-wrapper.jar

│ └── gradle-wrapper.properties

├── gradle.properties

├── gradlew

├── gradlew.bat

└── settings.gradle.kts

22 directories, 12 files

ライブラリプロジェクトの場合

> gradle init

Select type of build to generate:

1: Application

2: Library

3: Gradle plugin

4: Basic (build structure only)

Enter selection (default: Application) [1..4] 2

Select implementation language:

1: Java

2: Kotlin

3: Groovy

4: Scala

5: C++

6: Swift

Enter selection (default: Java) [1..6] 2

Enter target Java version (min: 7, default: 21): 21

Project name (default: tmp.vVJk4Hd6GU):

Select build script DSL:

1: Kotlin

2: Groovy

Enter selection (default: Kotlin) [1..2] 1

Select test framework:

1: kotlin.test

2: JUnit Jupiter

Enter selection (default: kotlin.test) [1..2] 1

Generate build using new APIs and behavior (some features may change in the next minor release)? (default: no) [yes, no]

> Task :init

> Learn more about Gradle by exploring our Samples at https://docs.gradle.org/8.14.2/samples/sample_building_kotlin_libraries.html

BUILD SUCCESSFUL in 9s

1 actionable task: 1 executed

.

├── gradle

│ ├── libs.versions.toml

│ └── wrapper

│ ├── gradle-wrapper.jar

│ └── gradle-wrapper.properties

├── gradle.properties

├── gradlew

├── gradlew.bat

├── lib

│ ├── build.gradle.kts

│ └── src

│ ├── main

│ │ ├── kotlin

│ │ │ └── org

│ │ │ └── example

│ │ │ └── Library.kt

│ │ └── resources

│ └── test

│ ├── kotlin

│ │ └── org

│ │ └── example

│ │ └── LibraryTest.kt

│ └── resources

└── settings.gradle.kts

15 directories, 10 files

生成されたソースファイル

cat app/src/main/kotlin/org/example/App.kt

/*

* This source file was generated by the Gradle 'init' task

*/

package org.example

class App {

val greeting: String

get() {

return "Hello World!"

}

}

fun main() {

println(App().greeting)

}

cat lib/src/main/kotlin/org/example/Library.kt

/*

* This source file was generated by the Gradle 'init' task

*/

package org.example

class Library {

fun someLibraryMethod(): Boolean {

return true

}

}

rust 同様、エントリーポイントになる main 関数が存在しない場合は Library となりそうだ。

kotlin.test もちょっと気になる

/*

* This source file was generated by the Gradle 'init' task

*/

package org.example

import kotlin.test.Test

import kotlin.test.assertNotNull

class AppTest {

@Test fun appHasAGreeting() {

val classUnderTest = App()

assertNotNull(classUnderTest.greeting, "app should have a greeting")

}

}

kotlin-test は kotest と改名された?らしい1 2

と思ったけど build.gradle 見てみたら

// Use the Kotlin JUnit 5 integration.

testImplementation("org.jetbrains.kotlin:kotlin-test-junit5")

// Use the JUnit 5 integration.

testImplementation(libs.junit.jupiter.engine)

JUnit やったし。

JUnit の特徴として、アノテーションが挙げられるらしい? kotest はBDD 形式というのが用いられてるとのこと。3

そもそも unit test ってなんだ。

単体テスト。

note

unit は単体、一人、一個、単位などを意味する名刺4

unit ってまとまったみたいな意味を持ってるのかと思ってたわ。

統合テスト、これは英語だと integration test になるらしい。 integration は統合って意味を持つのか。

漢字読み間違えてた。 結合じゃなくて統合か。

rust は統合テストをtestsディレクトリに、単体テストは大抵同じソースコードに書くけど、

kotlin(junit)は統合テストも単体テストもディレクトリが別れてるんだね。

あ、こら、rust が特殊とか言わない!

tip

この記事は決して日記さんがあふぉなことを証明するものではありません! ...多分

できることを知っておく

> gradle task

> Calculating task graph as no cached configuration is available for tasks: task

> Task :tasks

---

## Tasks runnable from root project 'tmp.q5kXPDaYCv'

## Application tasks

run - Runs this project as a JVM application

## Build tasks

assemble - Assembles the outputs of this project.

build - Assembles and tests this project.

buildDependents - Assembles and tests this project and all projects that depend on it.

buildKotlinToolingMetadata - Build metadata json file containing information about the used Kotlin tooling

buildNeeded - Assembles and tests this project and all projects it depends on.

classes - Assembles main classes.

clean - Deletes the build directory.

jar - Assembles a jar archive containing the classes of the 'main' feature.

kotlinSourcesJar - Assembles a jar archive containing the sources of target 'kotlin'.

testClasses - Assembles test classes.

## Build Setup tasks

init - Initializes a new Gradle build.

updateDaemonJvm - Generates or updates the Gradle Daemon JVM criteria.

wrapper - Generates Gradle wrapper files.

## Distribution tasks

assembleDist - Assembles the main distributions

distTar - Bundles the project as a distribution.

distZip - Bundles the project as a distribution.

installDist - Installs the project as a distribution as-is.

## Documentation tasks

javadoc - Generates Javadoc API documentation for the 'main' feature.

## Help tasks

artifactTransforms - Displays the Artifact Transforms that can be executed in root project 'tmp.q5kXPDaYCv'.

buildEnvironment - Displays all buildscript dependencies declared in root project 'tmp.q5kXPDaYCv'.

dependencies - Displays all dependencies declared in root project 'tmp.q5kXPDaYCv'.

dependencyInsight - Displays the insight into a specific dependency in root project 'tmp.q5kXPDaYCv'.

help - Displays a help message.

javaToolchains - Displays the detected java toolchains.

kotlinDslAccessorsReport - Prints the Kotlin code for accessing the currently available project extensions and conventions.

outgoingVariants - Displays the outgoing variants of root project 'tmp.q5kXPDaYCv'.

projects - Displays the sub-projects of root project 'tmp.q5kXPDaYCv'.

properties - Displays the properties of root project 'tmp.q5kXPDaYCv'.

resolvableConfigurations - Displays the configurations that can be resolved in root project 'tmp.q5kXPDaYCv'.

tasks - Displays the tasks runnable from root project 'tmp.q5kXPDaYCv' (some of the displayed tasks may belong to subprojects).

## Verification tasks

check - Runs all checks.

checkKotlinGradlePluginConfigurationErrors - Checks that Kotlin Gradle Plugin hasn't reported project configuration errors, failing otherwise. This task always runs before compileKotlin\* or similar tasks.

test - Runs the test suite.

To see all tasks and more detail, run gradle tasks --all

To see more detail about a task, run gradle help --task <task>

BUILD SUCCESSFUL in 6s

1 actionable task: 1 executed

Configuration cache entry stored.

gradle tasks はタスクというのを表示する。 tasks って自分で追加することもできるらしい。

気になった task 探索 1: javaToolchains

>gradle javaToolchains

Calculating task graph as no cached configuration is available for tasks: javaToolchains

> Task :javaToolchains

+ Options

| Auto-detection: Enabled

| Auto-download: Enabled

+ Azul Zulu JDK 1.8.0_432-b06

| Location: /Library/Java/JavaVirtualMachines/zulu-8.jdk/Contents/Home

| Language Version: 8

| Vendor: Azul Zulu

| Architecture: aarch64

| Is JDK: true

| Detected by: MacOS java_home

+ Azul Zulu JDK 17.0.13+11-LTS

| Location: /Library/Java/JavaVirtualMachines/zulu-17.jdk/Contents/Home

| Language Version: 17

| Vendor: Azul Zulu

| Architecture: aarch64

| Is JDK: true

| Detected by: Current JVM

+ Azul Zulu JDK 21.0.5+11-LTS

| Location: /Library/Java/JavaVirtualMachines/zulu-21.jdk/Contents/Home

| Language Version: 21

| Vendor: Azul Zulu

| Architecture: aarch64

| Is JDK: true

| Detected by: MacOS java_home

+ Azul Zulu JDK 23.0.1+11

| Location: /Library/Java/JavaVirtualMachines/zulu-23.jdk/Contents/Home

| Language Version: 23

| Vendor: Azul Zulu

| Architecture: aarch64

| Is JDK: true

| Detected by: MacOS java_home

+ Microsoft JDK 21.0.7+6-LTS

| Location: /Library/Java/JavaVirtualMachines/microsoft-21.jdk/Contents/Home

| Language Version: 21

| Vendor: Microsoft

| Architecture: aarch64

| Is JDK: true

| Detected by: MacOS java_home

BUILD SUCCESSFUL in 814ms

1 actionable task: 1 executed

Configuration cache entry stored.

ほへぇシステムにある Java 自動で検知してきてくれるんだ。 java_home で探したとも書かれてるね。

気になった task 探索 2: projects

>gradle projects

<Calculating task graph as no cached configuration is available for tasks: projects

> Task :projects

Projects:

------------------------------------------------------------

Root project 'tmp.vVJk4Hd6GU'

------------------------------------------------------------

Root project 'tmp.vVJk4Hd6GU'

\--- Project ':lib'

To see a list of the tasks of a project, run gradle <project-path>:tasks

For example, try running gradle :lib:tasks

BUILD SUCCESSFUL in 374ms

1 actionable task: 1 executed

Configuration cache entry stored.

プロジェクトが設定できるらしい。 試しに lib を lib2 として複製してみる。 これだけだと認識しない。

>cat settings.gradle.kts

/*

* This file was generated by the Gradle 'init' task.

*

* The settings file is used to specify which projects to include in your build.

* For more detailed information on multi-project builds, please refer to https://docs.gradle.org/8.14.2/userguide/multi_project_builds.html in the Gradle documentation.

*/

plugins {

// Apply the foojay-resolver plugin to allow automatic download of JDKs

id("org.gradle.toolchains.foojay-resolver-convention") version "0.10.0"

}

rootProject.name = "tmp.vVJk4Hd6GU"

include("lib")

+ include("lib2")

settings.gradle.ktsにそれっぽいこと(include)が書かれてるので追記。

結果、認識した

>gradle projects

Calculating task graph as configuration cache cannot be reused because file 'settings.gradle.kts' has changed.

> Task :projects

Projects:

------------------------------------------------------------

Root project 'tmp.vVJk4Hd6GU'

------------------------------------------------------------

Root project 'tmp.vVJk4Hd6GU'

+--- Project ':lib'

\--- Project ':lib2'

To see a list of the tasks of a project, run gradle <project-path>:tasks

For example, try running gradle :lib:tasks

BUILD SUCCESSFUL in 639ms

1 actionable task: 1 executed

Configuration cache entry stored.

なお、プロジェクトごとに task は異なる。

ここに書いてあるように、gradle <project-path>:tasksで各プロジェクトの tasks 一覧を取得できる。

gradle tasks --allを実行すると、すべての task を表示できる。

>gradle tasks --all

Calculating task graph as no cached configuration is available for tasks: tasks --all

> Task :tasks

------------------------------------------------------------

Tasks runnable from root project 'tmp.vVJk4Hd6GU'

------------------------------------------------------------

Build tasks

-----------

lib:assemble - Assembles the outputs of this project.

lib2:assemble - Assembles the outputs of this project.

lib:build - Assembles and tests this project.

lib2:build - Assembles and tests this project.

lib:buildDependents - Assembles and tests this project and all projects that depend on it.

lib2:buildDependents - Assembles and tests this project and all projects that depend on it.

lib:buildKotlinToolingMetadata - Build metadata json file containing information about the used Kotlin tooling

lib2:buildKotlinToolingMetadata - Build metadata json file containing information about the used Kotlin tooling

lib:buildNeeded - Assembles and tests this project and all projects it depends on.

lib2:buildNeeded - Assembles and tests this project and all projects it depends on.

lib:classes - Assembles main classes.

lib2:classes - Assembles main classes.

lib:clean - Deletes the build directory.

lib2:clean - Deletes the build directory.

lib:jar - Assembles a jar archive containing the classes of the 'main' feature.

lib2:jar - Assembles a jar archive containing the classes of the 'main' feature.

lib:kotlinSourcesJar - Assembles a jar archive containing the sources of target 'kotlin'.

lib2:kotlinSourcesJar - Assembles a jar archive containing the sources of target 'kotlin'.

lib:testClasses - Assembles test classes.

lib2:testClasses - Assembles test classes.

Build Setup tasks

-----------------

init - Initializes a new Gradle build.

updateDaemonJvm - Generates or updates the Gradle Daemon JVM criteria.

wrapper - Generates Gradle wrapper files.

Documentation tasks

-------------------

lib:javadoc - Generates Javadoc API documentation for the 'main' feature.

lib2:javadoc - Generates Javadoc API documentation for the 'main' feature.

Help tasks

----------

artifactTransforms - Displays the Artifact Transforms that can be executed in root project 'tmp.vVJk4Hd6GU'.

lib:artifactTransforms - Displays the Artifact Transforms that can be executed in project ':lib'.

lib2:artifactTransforms - Displays the Artifact Transforms that can be executed in project ':lib2'.

buildEnvironment - Displays all buildscript dependencies declared in root project 'tmp.vVJk4Hd6GU'.

lib:buildEnvironment - Displays all buildscript dependencies declared in project ':lib'.

lib2:buildEnvironment - Displays all buildscript dependencies declared in project ':lib2'.

dependencies - Displays all dependencies declared in root project 'tmp.vVJk4Hd6GU'.

lib:dependencies - Displays all dependencies declared in project ':lib'.

lib2:dependencies - Displays all dependencies declared in project ':lib2'.

dependencyInsight - Displays the insight into a specific dependency in root project 'tmp.vVJk4Hd6GU'.

lib:dependencyInsight - Displays the insight into a specific dependency in project ':lib'.

lib2:dependencyInsight - Displays the insight into a specific dependency in project ':lib2'.

help - Displays a help message.

lib:help - Displays a help message.

lib2:help - Displays a help message.

javaToolchains - Displays the detected java toolchains.

lib:javaToolchains - Displays the detected java toolchains.

lib2:javaToolchains - Displays the detected java toolchains.

lib:kotlinDslAccessorsReport - Prints the Kotlin code for accessing the currently available project extensions and conventions.

lib2:kotlinDslAccessorsReport - Prints the Kotlin code for accessing the currently available project extensions and conventions.

outgoingVariants - Displays the outgoing variants of root project 'tmp.vVJk4Hd6GU'.

lib:outgoingVariants - Displays the outgoing variants of project ':lib'.

lib2:outgoingVariants - Displays the outgoing variants of project ':lib2'.

projects - Displays the sub-projects of root project 'tmp.vVJk4Hd6GU'.

lib:projects - Displays the sub-projects of project ':lib'.

lib2:projects - Displays the sub-projects of project ':lib2'.

properties - Displays the properties of root project 'tmp.vVJk4Hd6GU'.

lib:properties - Displays the properties of project ':lib'.

lib2:properties - Displays the properties of project ':lib2'.

resolvableConfigurations - Displays the configurations that can be resolved in root project 'tmp.vVJk4Hd6GU'.

lib:resolvableConfigurations - Displays the configurations that can be resolved in project ':lib'.

lib2:resolvableConfigurations - Displays the configurations that can be resolved in project ':lib2'.

tasks - Displays the tasks runnable from root project 'tmp.vVJk4Hd6GU' (some of the displayed tasks may belong to subprojects).

lib:tasks - Displays the tasks runnable from project ':lib'.

lib2:tasks - Displays the tasks runnable from project ':lib2'.

Verification tasks

------------------

lib:check - Runs all checks.

lib2:check - Runs all checks.

lib:checkKotlinGradlePluginConfigurationErrors - Checks that Kotlin Gradle Plugin hasn't reported project configuration errors, failing otherwise. This task always runs before compileKotlin* or similar tasks.

lib2:checkKotlinGradlePluginConfigurationErrors - Checks that Kotlin Gradle Plugin hasn't reported project configuration errors, failing otherwise. This task always runs before compileKotlin* or similar tasks.

lib:test - Runs the test suite.

lib2:test - Runs the test suite.

Other tasks

-----------

lib:compileJava - Compiles main Java source.

lib2:compileJava - Compiles main Java source.

lib:compileKotlin - Compiles the compilation 'main' in target ''.

lib2:compileKotlin - Compiles the compilation 'main' in target ''.

lib:compileTestJava - Compiles test Java source.

lib2:compileTestJava - Compiles test Java source.

lib:compileTestKotlin - Compiles the compilation 'test' in target ''.

lib2:compileTestKotlin - Compiles the compilation 'test' in target ''.

components - Displays the components produced by root project 'tmp.vVJk4Hd6GU'. [deprecated]

lib:components - Displays the components produced by project ':lib'. [deprecated]

lib2:components - Displays the components produced by project ':lib2'. [deprecated]

dependentComponents - Displays the dependent components of components in root project 'tmp.vVJk4Hd6GU'. [deprecated]

lib:dependentComponents - Displays the dependent components of components in project ':lib'. [deprecated]

lib2:dependentComponents - Displays the dependent components of components in project ':lib2'. [deprecated]

+ lib2:hello

lib:mainClasses

lib2:mainClasses

model - Displays the configuration model of root project 'tmp.vVJk4Hd6GU'. [deprecated]

lib:model - Displays the configuration model of project ':lib'. [deprecated]

lib2:model - Displays the configuration model of project ':lib2'. [deprecated]

prepareKotlinBuildScriptModel

lib:processResources - Processes main resources.

lib2:processResources - Processes main resources.

lib:processTestResources - Processes test resources.

lib2:processTestResources - Processes test resources.

BUILD SUCCESSFUL in 467ms

1 actionable task: 1 executed

Configuration cache entry stored.

(せっかくなので lib2 に独自のタスクを設定してみた。)

task を独自で定義する

tasks.register("hello") {

doLast {

println("Hello world!")

}

}

公式サイト を元に定義、というかほぼコピー

register のコールバックとして、doLast を定義してると考えるのがいいのかね?

マインクラフトと gradle

マインクラフトの mod 開発は、大抵 gralde となる。

作るもの、使う前提 mod などによってセットアップが大きく異なる。

paper の場合

gralde をライブラリで初期化し、次のページに書かれている内容を build.gradle.kts に追加する。 Project setup | PaperMC Docs

ちなみに、kotlin で開発できる(と思う)

kotlin にして問題があったら随時ページを更新します。

一例

>gradle init

Select type of build to generate:

1: Application

2: Library

3: Gradle plugin

4: Basic (build structure only)

Enter selection (default: Application) [1..4] 2

Select implementation language:

1: Java

2: Kotlin

3: Groovy

4: Scala

5: C++

6: Swift

Enter selection (default: Java) [1..6] 2

Enter target Java version (min: 7, default: 21): 21

Project name (default: tmp.1mPA8JuPth):

Select build script DSL:

1: Kotlin

2: Groovy

Enter selection (default: Kotlin) [1..2] 1

Select test framework:

1: kotlin.test

2: JUnit Jupiter

Enter selection (default: kotlin.test) [1..2] 1

Generate build using new APIs and behavior (some features may change in the next minor release)? (default: no) [yes, no]

> Task :init

Learn more about Gradle by exploring our Samples at https://docs.gradle.org/8.14.2/samples/sample_building_kotlin_libraries.html

BUILD SUCCESSFUL in 11s

1 actionable task: 1 executed

cat build.gradle.kts

/*

* This file was generated by the Gradle 'init' task.

*

* This generated file contains a sample Kotlin library project to get you started.

* For more details on building Java & JVM projects, please refer to https://docs.gradle.org/8.14.2/userguide/building_java_projects.html in the Gradle documentation.

*/

plugins {

// Apply the org.jetbrains.kotlin.jvm Plugin to add support for Kotlin.

alias(libs.plugins.kotlin.jvm)

// Apply the java-library plugin for API and implementation separation.

`java-library`

}

repositories {

// Use Maven Central for resolving dependencies.

mavenCentral()

// Paper用に追加

maven {

name = "papermc"

url = uri("https://repo.papermc.io/repository/maven-public/")

}

}

dependencies {

// Use the Kotlin JUnit 5 integration.

testImplementation("org.jetbrains.kotlin:kotlin-test-junit5")

// Use the JUnit 5 integration.

testImplementation(libs.junit.jupiter.engine)

testRuntimeOnly("org.junit.platform:junit-platform-launcher")

// This dependency is exported to consumers, that is to say found on their compile classpath.

api(libs.commons.math3)

// This dependency is used internally, and not exposed to consumers on their own compile classpath.

implementation(libs.guava)

// Paper用に追加

compileOnly("io.papermc.paper:paper-api:1.21.8-R0.1-SNAPSHOT")

}

// Apply a specific Java toolchain to ease working on different environments.

java {

toolchain {

languageVersion = JavaLanguageVersion.of(21)

}

}

tasks.named<Test>("test") {

// Use JUnit Platform for unit tests.

useJUnitPlatform()

}

repositories {

}

dependencies {

compileOnly("io.papermc.paper:paper-api:1.21.8-R0.1-SNAPSHOT")

}

java {

toolchain.languageVersion.set(JavaLanguageVersion.of(21))

}

ここまでおわったらgradle checkを実行しておく

必要そうな gradle プラグインを追加する

shadowというのが必要です。 fat-jar を生成します。

依存関係を含め必要なファイルをすべてjarファイルに保存します。5

導入は簡単ですが、最新版を入れたら動作しなかったので、その辺は調整してください。

/*

* This file was generated by the Gradle 'init' task.

*

* This generated file contains a sample Kotlin library project to get you started.

* For more details on building Java & JVM projects, please refer to https://docs.gradle.org/8.14.2/userguide/building_java_projects.html in the Gradle documentation.

*/

plugins {

// Apply the org.jetbrains.kotlin.jvm Plugin to add support for Kotlin.

alias(libs.plugins.kotlin.jvm)

// Apply the java-library plugin for API and implementation separation.

`java-library`

// shadow jarを導入

id("com.gradleup.shadow") version "8.3.8"

}

最新版を入れた時に発生したエラー

9.0.0-rc2 で発生したエラー

(検証日: 2025/07/28)

Caused by: java.lang.RuntimeException: Failed to remap plugin jar '/<個人情報を含むため省略>/tmp.1mPA8JuPth/lib/build/libs/lib-all.jar'

便利そうな gradle プラグインを追加する

run-taskというのが便利そうなので追加する。

/*

* This file was generated by the Gradle 'init' task.

*

* This generated file contains a sample Kotlin library project to get you started.

* For more details on building Java & JVM projects, please refer to https://docs.gradle.org/8.14.2/userguide/building_java_projects.html in the Gradle documentation.

*/

plugins {

// Apply the org.jetbrains.kotlin.jvm Plugin to add support for Kotlin.

alias(libs.plugins.kotlin.jvm)

// Apply the java-library plugin for API and implementation separation.

`java-library`

// Apply the plugin (run-task用に追加)

id("xyz.jpenilla.run-paper") version "2.3.1"

}

repositories {

// Use Maven Central for resolving dependencies.

mavenCentral()

// Paper用に追加

maven {

name = "papermc"

url = uri("https://repo.papermc.io/repository/maven-public/")

}

}

dependencies {

// Use the Kotlin JUnit 5 integration.

testImplementation("org.jetbrains.kotlin:kotlin-test-junit5")

// Use the JUnit 5 integration.

testImplementation(libs.junit.jupiter.engine)

testRuntimeOnly("org.junit.platform:junit-platform-launcher")

// This dependency is exported to consumers, that is to say found on their compile classpath.

api(libs.commons.math3)

// This dependency is used internally, and not exposed to consumers on their own compile classpath.

implementation(libs.guava)

// Paper用に追加

compileOnly("io.papermc.paper:paper-api:1.21.8-R0.1-SNAPSHOT")

}

// Apply a specific Java toolchain to ease working on different environments.

java {

toolchain {

languageVersion = JavaLanguageVersion.of(21)

}

}

tasks.named<Test>("test") {

// Use JUnit Platform for unit tests.

useJUnitPlatform()

}

repositories {

}

dependencies {

compileOnly("io.papermc.paper:paper-api:1.21.8-R0.1-SNAPSHOT")

}

java {

toolchain.languageVersion.set(JavaLanguageVersion.of(21))

}

// run-task用に追加

// 公式と書き方が異なるので注意

tasks.runServer {

minecraftVersion("1.21.8") // バージョン指定

}

kotlin でコードを書いてみる

paper のサイトに公開されてるページを kotlin ベースに書き直すとこうなる

package org.adw39.examplePlugin

import net.kyori.adventure.text.Component

import org.bukkit.Bukkit

import org.bukkit.event.Listener

import org.bukkit.event.player.PlayerJoinEvent

import org.bukkit.plugin.java.JavaPlugin

class ExamplePlugin: JavaPlugin(), Listener {

override fun onEnable() {

Bukkit.getPluginManager().registerEvents(this, this)

}

@EventHandler

fun onPlayerJoin(event: PlayerJoinEvent) {

event.player.sendMessage("hello!")

}

}

- 関数の定義は rust などに似てる

funを先頭につける。 void 以外の戻り値は、()の後ろに(): <Type>です。 @Overrideはoverrideを先頭につける

しょっちゅう使われるから言語標準で用意されたのかな- java の

getHogehoge、setHogehogeメソッドは、get/set を省略する

いわゆるゲッターセッターってやつです。 kotlin の場合は基本的に省略可能です。

plugin.ymlを忘れない

拡張子yamlは NG6

name: ExamplePlugin

version: 1.0.0

main: org.adw39.examplePlugin.ExamplePlugin

description: An example plugin

author: nikki9750

website: https://adw39.org

api-version: "1.21.8"

runServer を実行する

サーバーが起動したら成功

サーバーの軌道に失敗したら、まず/lib/runに生成されるサーバーディレクトリの、elua.txtを確認すること

参考

基礎編 part2+

前回 sdkman が使いやすいというお話を致しました。

そして、コマンドラインの gradle で、プロジェクトを作成したのでした。

投稿日とバージョンについて

後述しますが、gradle はバージョンによっての変化が激しいため、先に日程と gradle の最新版の確認をお願いします。

なお、日記さん側でも変化があったら修正するよう心掛けるつもりではありますが、放置する可能性もあるのでよろしくお願いします。

- 投稿日: 2025/07/28

- Gradle の Version:

Gradle 8.14.2 - IntelliJ Idea の Version:

IntelliJ IDEA 2025.1.4.1 (Ultimate Edition) - そもそも使ってる OS:

MacOS 15.5(24F74)

🎵 本日の一曲

まほうつかってりめせかをかがみごしにえいえんにみてたい

intelliJ Idea はいいぞ

OSS 版もある IntelliJ Idea。

本来は有償エディタなのですが、機能制限付き(というより、Jetbrains 製のプラグインが使えない?)オープンソース版 IntelliJ Idea は無料で使えます。

また、学生なら有償版も無料で使えます。

JetBrains Student Pack

IntelliJ Idea を入れてみよう。

ダウンロードページ 普通に入れてください。 普通に。

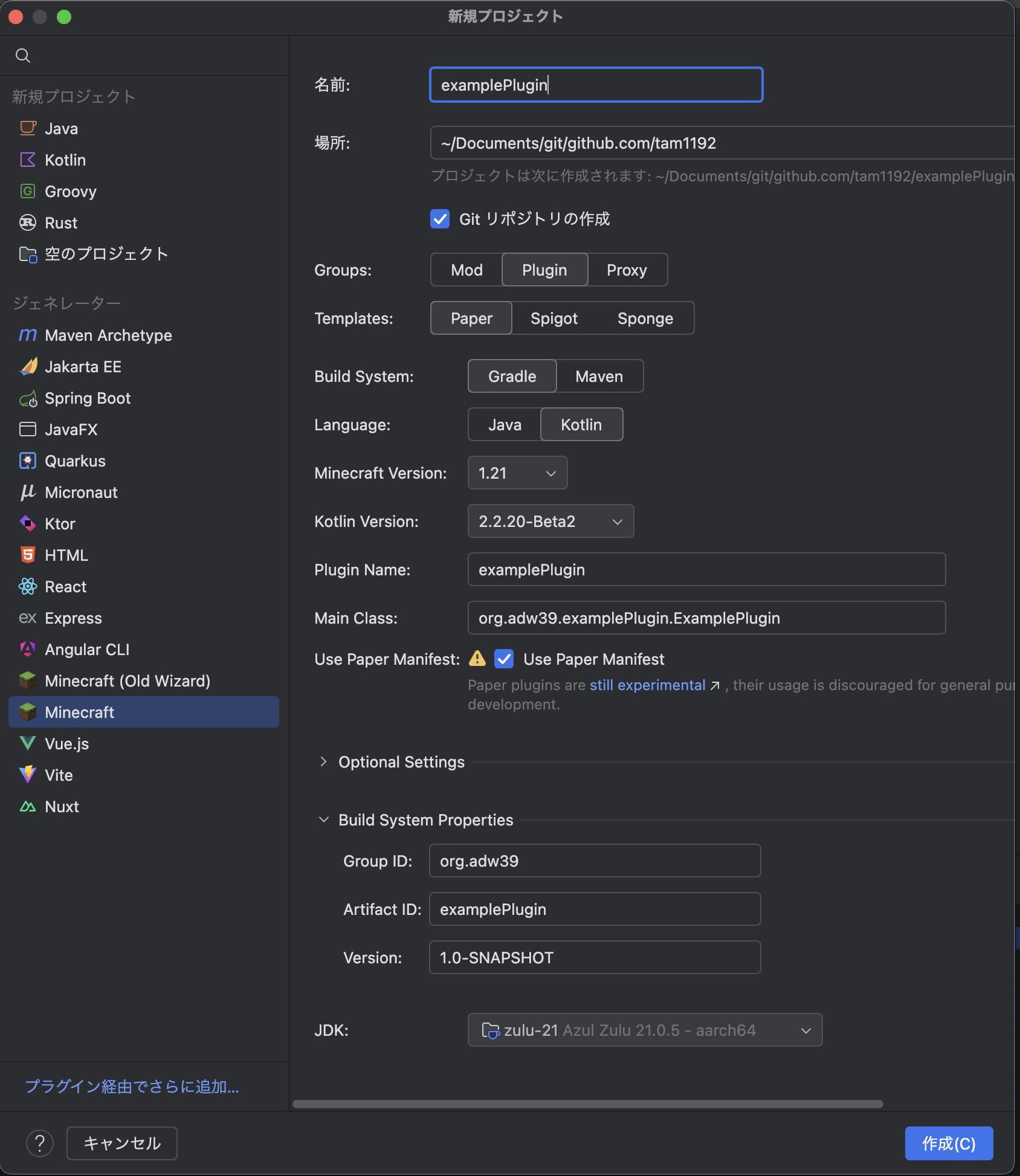

(本題)マインクラフトプラグインを入れる

IntelliJ Idea のプラグインとして存在してます。

前回やった gradle などの設定を大体すべて自動でやってくれる優れものです。

起動時のプロジェクト選択画面、もしくはエディタ右上の歯車アイコンにある「プラグイン」というボタンから、導入できます。

プロジェクトを作ってみる

こんな感じで設定できます。 楽です。正直。

paper 編

PaperMCプラグインを作る時の備忘録です。

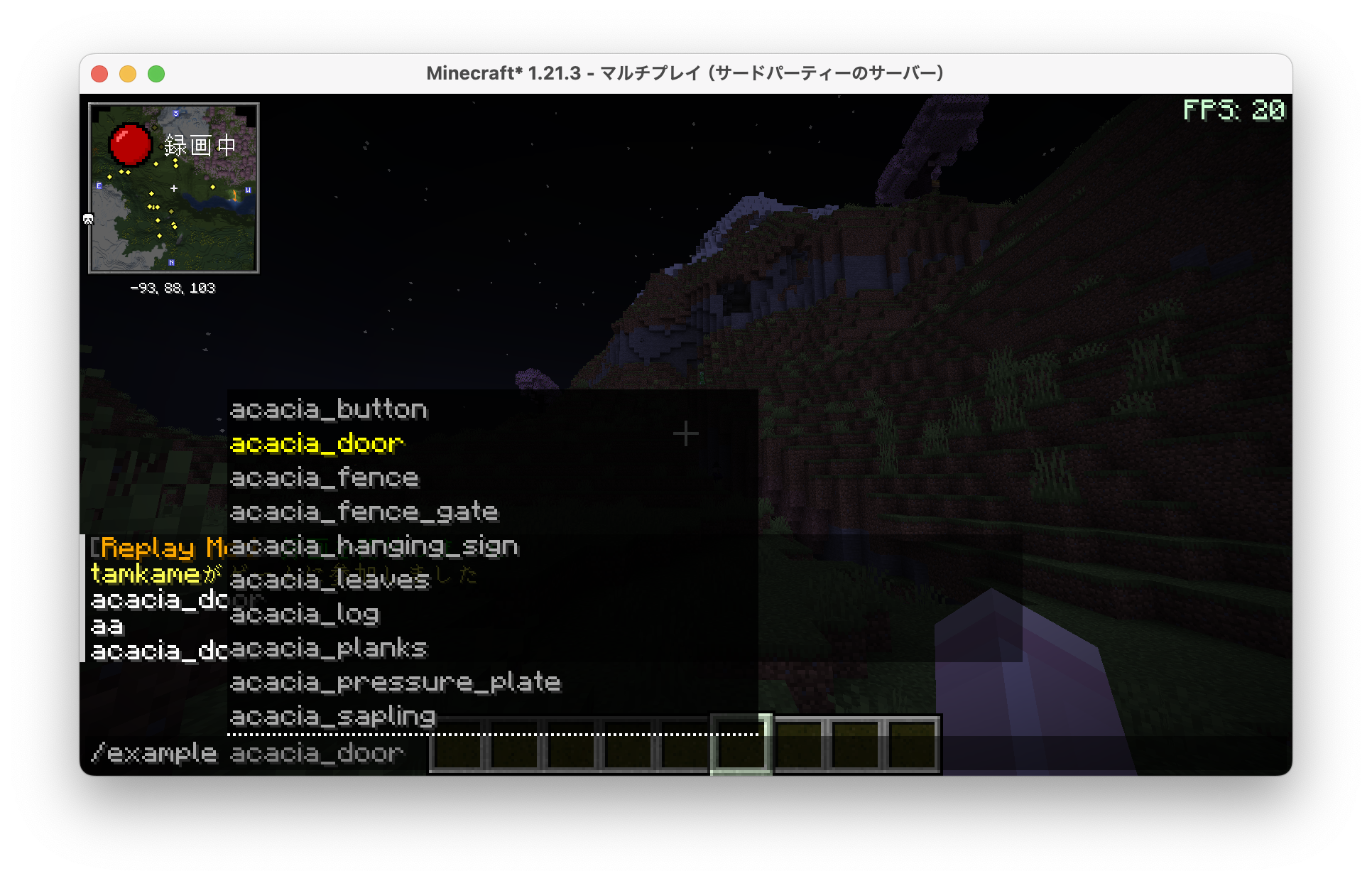

paper 編 part1 コマンド補完

基本中の基本でありながら早速引っ掛けがあったのでメモ

🎵 本日の一曲

pv がしぬほどかわいい。

CommandExecutor vs TabExecutor

---

config:

class:

hideEmptyMembersBox: true

---

classDiagram

direction TB

class CommandExecutor {